★ Революція Штучного Інтелекту: Шлях до Суперінтелекту

Чи ви пам’ятаєте, як нещодавно комп’ютер пройшов тест Тьюрінга? Пропоную розібратись з тим, що таке суперінтелект, чого нам від нього очікувати і куди взагалі ведуть нас сучасні комп’ютерні технології. В цьому дописі переклад відразу 2-х частин статті. Щоб ви були готові — це лонгрід.

Ми на порозі четвертої технологічної революції, але яку можна порівняти лише з виникненням людського життя на Землі. — Vernor Vinge

І як це бути на порозі технологічної революції?

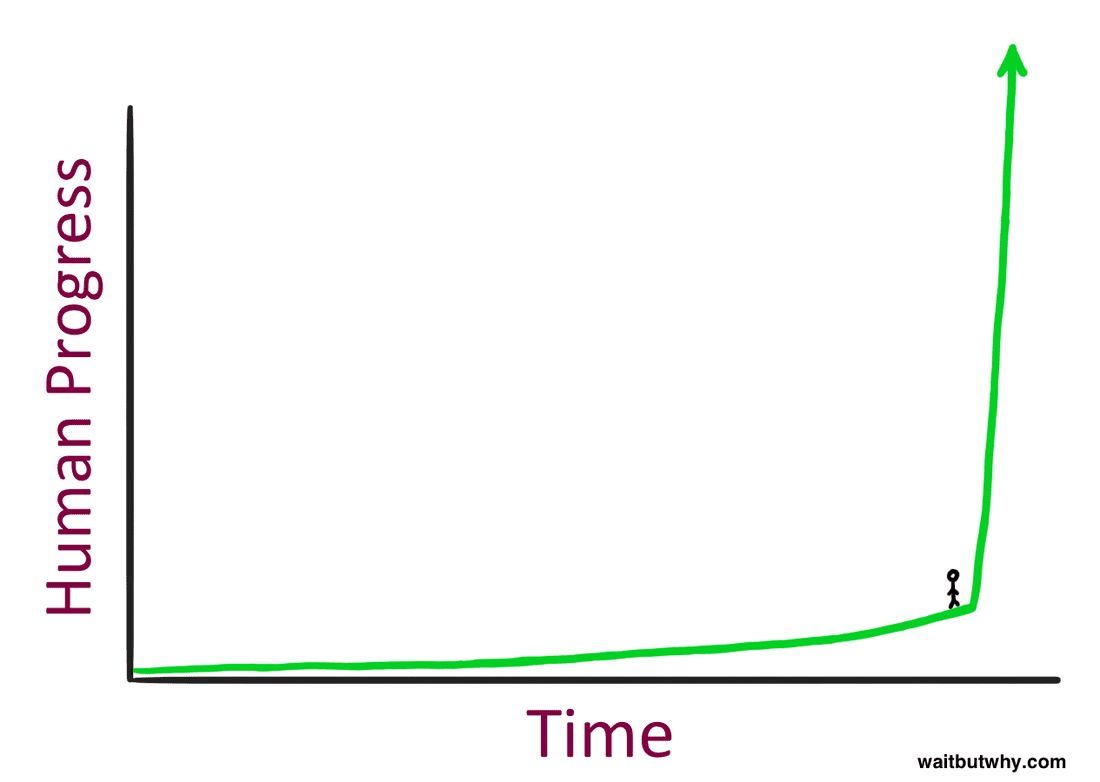

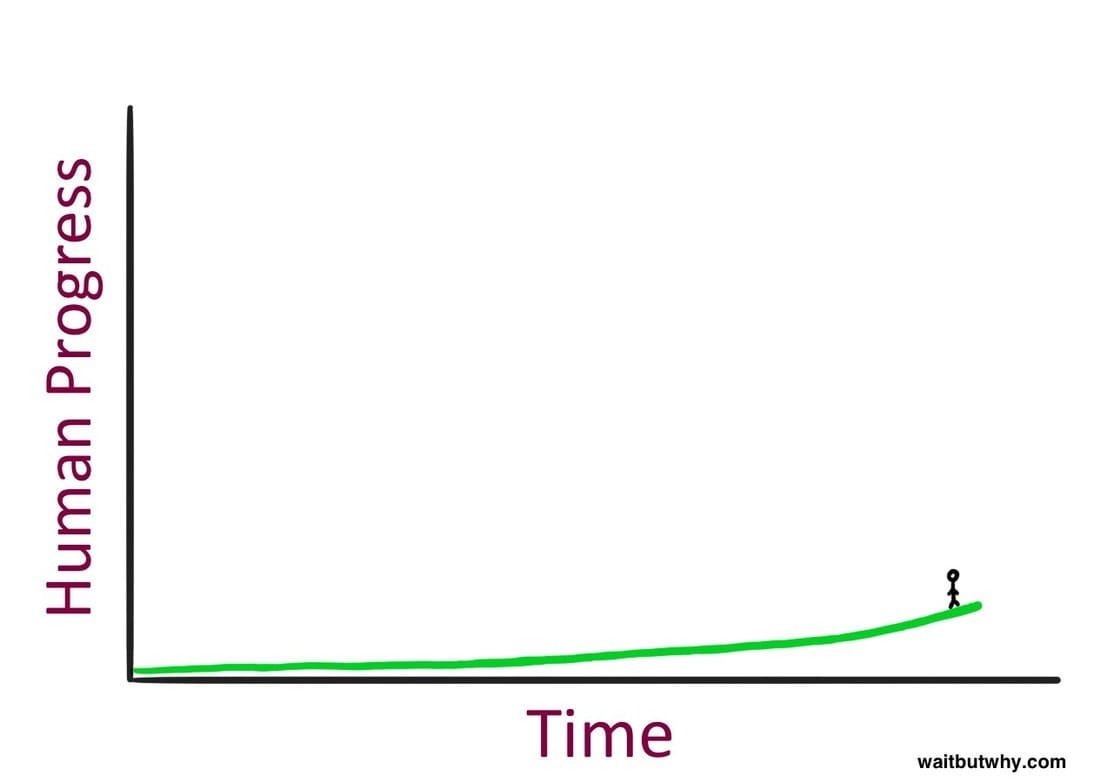

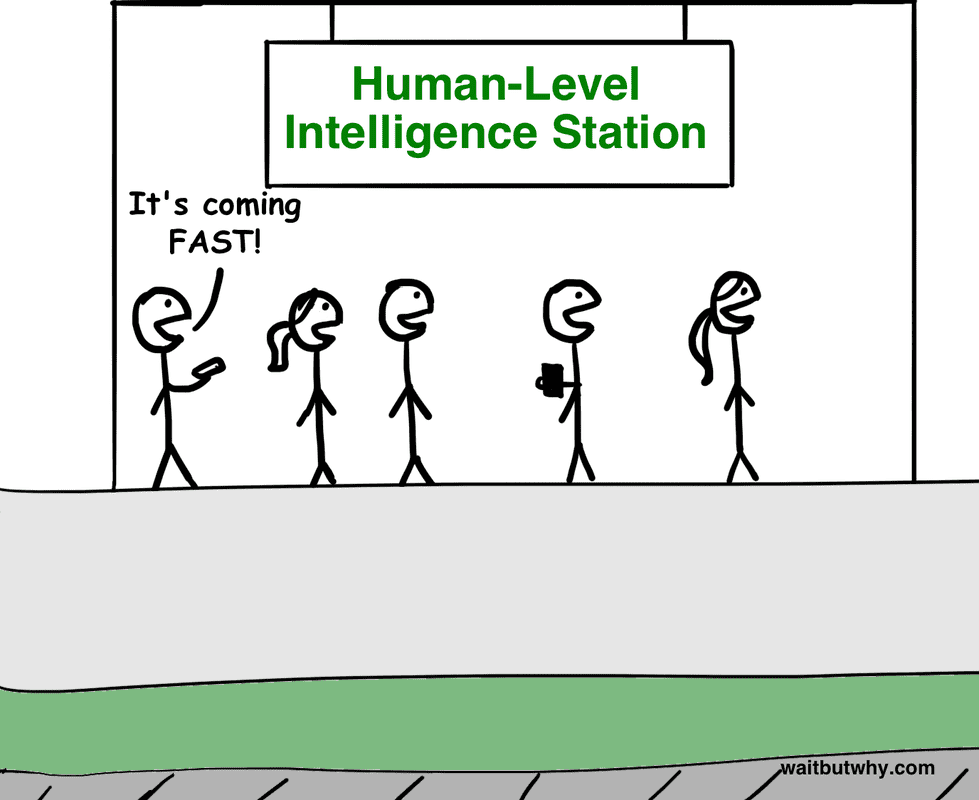

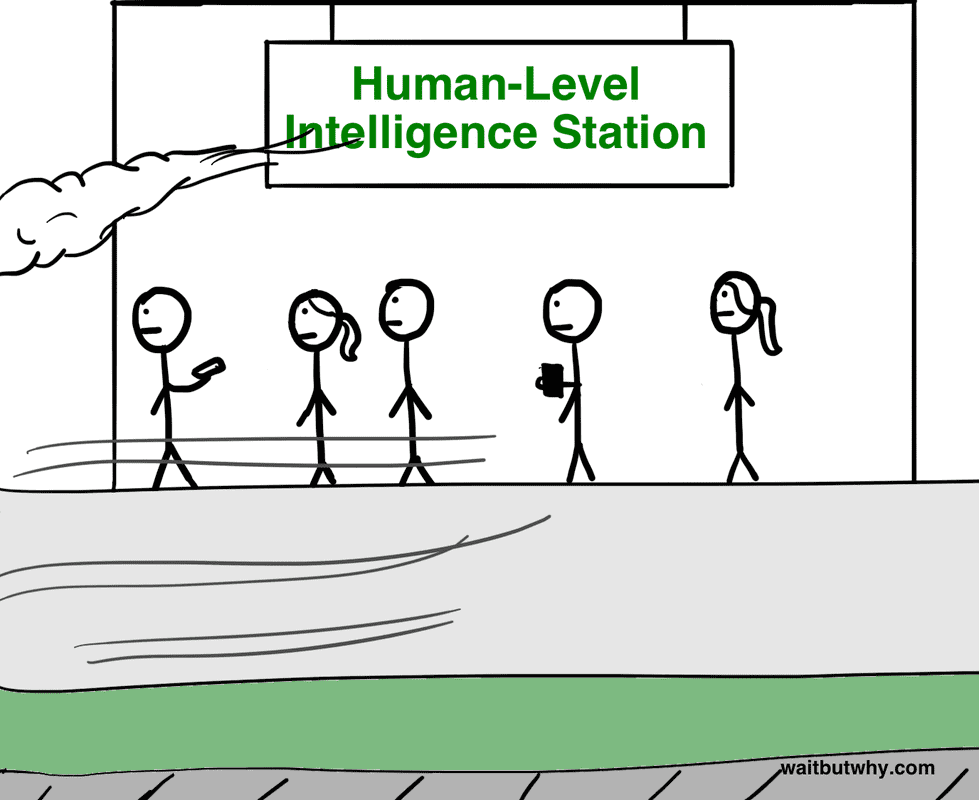

Це, мабуть, так хвилююче, але згадайте одну важливу річ: коли ви знаходитесь на тимчасовому графіку функції, ви не бачите, що знаходиться праворуч від вас. Насправді, знаходитись на порозі технологічної революції — це ось так:

І за відчуттями, швидше за все, в цьому немає нічого особливого..

Далеке майбутнє настане дуже скоро

Уявіть собі, наче ви відправляєтесь за допомогою машини часу в 1750 рік. Час, де постійно відключене світло, а для комунікації на великих відстанях потрібно або кричати, або стріляти в повітря з гармати, а весь транспорт заправляється сіном. Ось ви опинились там і одразу берете випадкового чоловіка і привозите його назад в 2017, возите його по різних місцях і спостерігаєте за його реакцією. Неможливо навіть уявити, що він відчуває, коли вперше в житті бачить на дорогах блискучі капсули, як це — поговорити з людьми, які знаходяться на іншому кінці світу, подивитись спортивний матч, який проводиться за тисячі кілометрів від вас, послухати музичний виступ, записаний півстоліття тому. Потім ми даємо йому погратись з чарівним прямокутником, за допомогою якого він може зафіксувати рухомі зображення, накреслити карту із загадковою блакитною точкою, яка вказує його місце розташування, побачитись і поговорити з кимось, хто перебуває на іншому кінці світу і створити ще багато інших чудес. І все це до того, як ви почнете йому пояснювати, що таке інтернет, віртуальна реальність, міжнародна космічна станція, адронний коллайдер, ядерна зброя і загальна теорія відносності.

Все це не просто б здивувало і шокувало його, чоловік міг би просто померти.

Але ось цікава річ — якби потім цей же чоловік відправився назад в свій 1750 і через надмірну цікавість вирішив здивувати когось так само як ми здивували його, і привіз хлопця з 1500 року, то другий, звичайно, здивувався б безлічі речей, але точно б не помер би від враження. Для нього такий досвід не став би шокуючою пригодою, бо хоч і 1750 і 1500 були різними, вони не були настільки різними, як і 1750 і 2015. Хлопець з 1500, звичайно, дізнався б вражаючі речі про простір і фізику і був би здивований тим, як сильно Європу охопили її імперіалістичні ідеї, а також йому довелося б значно переосмислити карту світу. Але повсякденне життя — пересування, комунікації і т.п. явно б його не вбили.

Далі, для того, щоб чоловіку з 1750 побавитись з кимось як ми побавились з ним, йому доведеться відправитись у більш ранню добу, десь в 12000 до Різдва Христового, до першої аграрної революції, яка заклала фундамент у розвитку перших міст і цивілізацій. Якби хтось із епохи полювання побачив людську імперію з величними соборами, кораблями які перетинають океани, і всіма накопиченими знаннями і відкриттями, то він би, швидше за все, помер.

Що якщо після смерті він би від заздрощів вирішив зробити те ж саме з кимось із минулого, відправився б у 24000 рік до Різдва Христового і взяв звідти людину, показав би їй все, і той би промовив: «Ну добре, і що з того?». Для того, щоб з людиною з 12 століття до Різдва Христового відтворити той же ефект, їй потрібно було б відправитись ще на 100 000 років в минуле і продемонструвати там вербальну комунікацію і вогонь.

Таким чином, для того, щоб померти, відчуваючи шок від побаченого людиною прогресу, потрібно відправитись в майбутнє на стільки років вперед, щоб досягти одиниці «смертельний рівень прогресу» (СРП). За часів полювання СРП дорівнювала 100000 років, але після аграрної революції вона стала дорівнювати всього 12000 років, а в результаті постіндустріальної революції світ став розвиватися так стрімко, що людині з 1750 року треба відправитись всього на кілька століть вперед, щоб досягти СРП.

Таку модель, при якій людський прогрес рухається швидше з кожним роком, футуролог Реймонд Курцвейл назвав Законом Прискореної Віддачі. Все просто: так відбувається, тому що більш розвиненому суспільству потрібно менше часу для прогресу, ніж менш розвиненому. У 19 столітті людство знало більше і володіло більш досконалими технологіями, ніж в 15 столітті, люди 15 століття не витрамали б жодної конкуренції з людьми 19 століття.

Це правило працює і в менших масштабах. Фільм «Назад в Майбутнє» вийшов в 1985 році, за сюжетом «минуле» відбувалось в 1955 році. Опинившись в 1955 році, герой Майкла Джея Фокса дивується ціною на газовану воду, застарілим телепрограмам і відмінностям в слензі. Так, для нього це був інший світ, але якби герою довелося відправитись з сьогоднішнього дня у 1985, то в картині було б більше жартів, пов’язаних з відмінностями. Герой потрапив би у світ без персональних комп’ютерів, інтернету і мобільного зв’язку. Сьогоднішній Марті Макфлай, тінейджер, що народився в 90х, відчував би себе не в своїй тарілці в 1985 куди більше, ніж кіно-персонаж Марті Макфлай який відчуває себе в 1955 році.

Через цю саму причину я пригадав про Закон Прискореної Віддачі. Середній темп розвитку між 1985 і 2015 набагато вище, ніж між 1955 і 1985. Перший проміжок охоплює стрімке зростання в розвитку, набагато більше змін відбулося за останні 30 років, ніж за 30 років до них.

Виходить, темп прогресу тільки прискорюється. Це означає, що наше майбутнє буде до дідька крутим, вірно?

Курцвейл стверджує, що всі досягнення XX століття вмістилися б у 20 років при темпі розвитку 2000 року, іншими словами, до 2000 року темп розвитку був в 5 разів вище, ніж середній темп розвитку в XX столітті. Він також вважає що прогрес, який можна порівняти з усіма досягненнями минулого століття, стався в період між 2000 і 2014 і такий же сукупний результат повториться наступного разу до 2021 року, всього за 7 років. Через кілька десятиліть досягнення, співставні з сумарним прогресом XX століття, будуть повторюватись кілька разів на рік, а ще пізніше — взагалі кожен місяць. В кінцевому підсумку, відповідно до Закону Прискореної віддачі, XXI століття перевищить прогрес XX століття в 1000 разів.

Якщо Курцвейл і всі, хто з ним погоджуються, мають рацію, то ми будемо також шоковані 2030 роком, як наш чоловік із 1750 був шокований в 2015. Тобто наступна СРП буде займати 20 років, і світ в 2050 буде настільки відмінний від теперішнього, що ми його просто не впізнаємо.

І це не наукова фантастика. В цьому твердо переконані багато науковців, які розумніші за нас. Якщо поглянути на історію, саме таке передбачення майбутнього найбільш логічне.

Звичайно, ви мені не повірите, якщо я скажу, що через 35 років світ буде радикально іншим. І ось з яких причин:

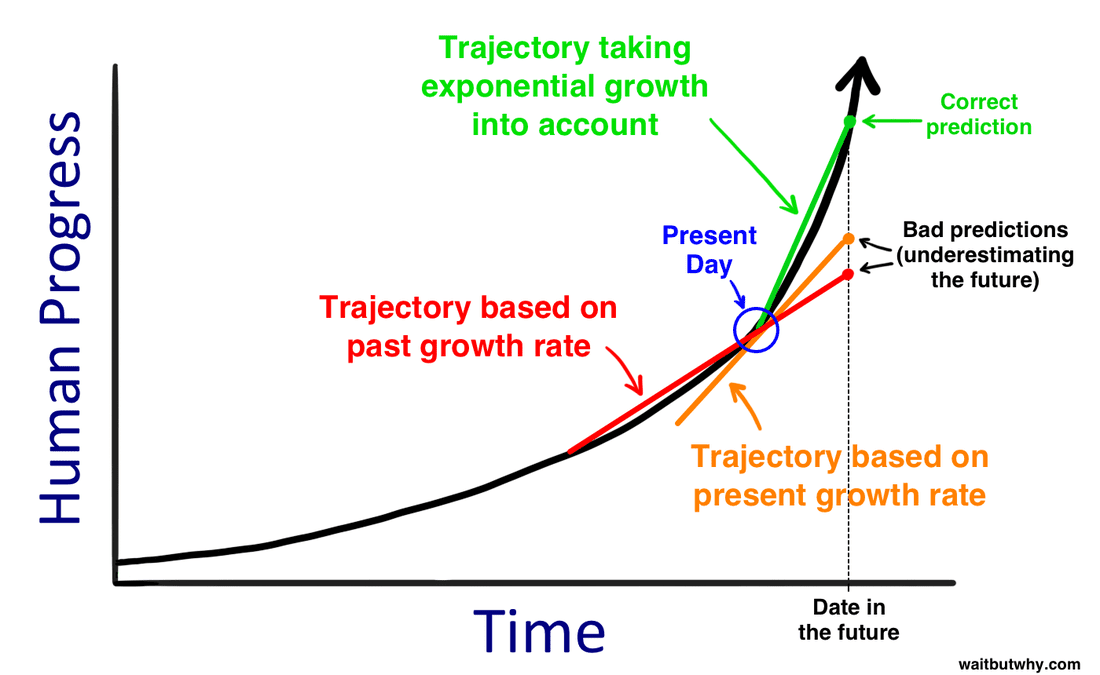

1) Коли справа доходить до історії, ми мислимо прямими лініями. Ми уявляємо собі прогрес наступних 30 років, сприймаючи прогрес попередніх 30 років як певний загальний орієнтир. Розмірковуючи про те, як зміниться світ за це сторіччя, ми просто мислимо про всі досягнення XX століття і додаємо певний їх еквівалент до 2000 року. Цієї ж помилки припустився чоловік з 1750 року, коли привіз першого хлопця з минулого з надією вразити його так само, як був вражений він сам, коли побував в майбутньому. Лінійне мислення є для нас інтуїтивним, в той час як нам слід мислити експоненційно. Той, хто виявився розумніше, зможе передбачити прогрес наступних 30 років, беручи до уваги нинішній темп розвитку і відштовхуючись вже від нього. Його передбачення виявилися б більш точними, але все одно дуже далекими від істини. Щоб думати про майбутнє правильно, слід уявляти собі більш високі швидкості розвитку, ніж ті, при яких ми живемо зараз.

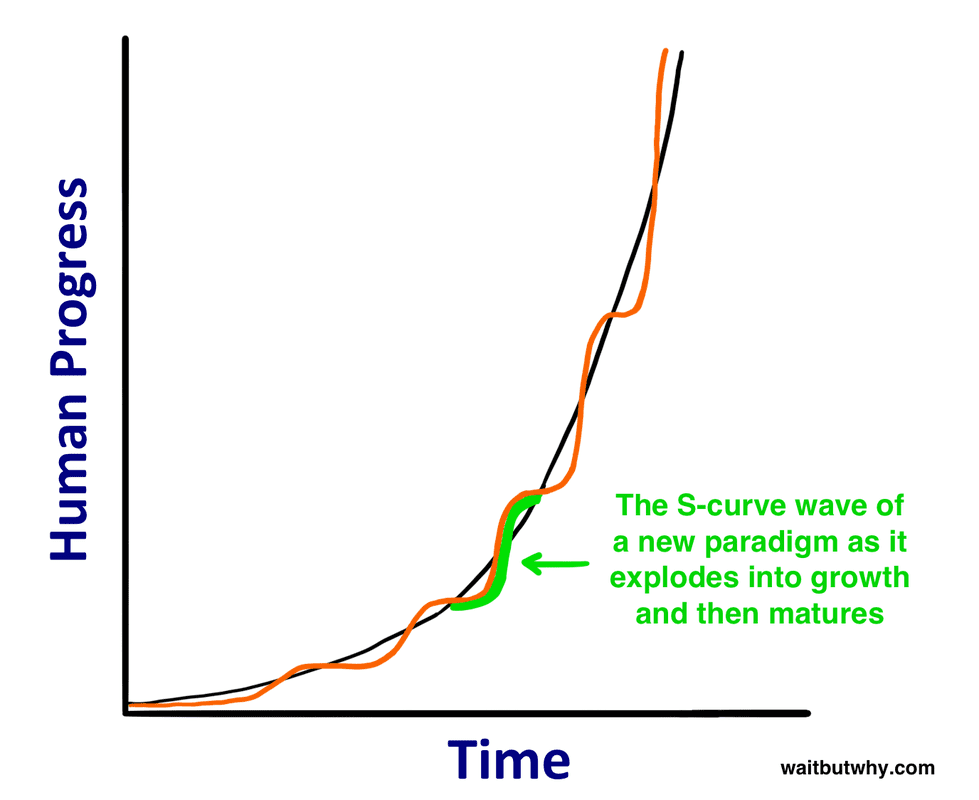

2) Траєкторія новітньої історії часто призводить нас до плутанини. По-перше, навіть найкрутіша експонента здається прямою, якщо споглядати на дуже короткий її відрізок. По-друге, експоненціальне зростання не ідеально гладке і однорідне. На думку Курцвейла, прогрес відбувається в S-подібних кривих:

S створюється хвилею прогресу, яка настає з утворенням нової парадигми. Вигин проходить три фази:

повільне зростання (рання фаза експоненціального зростання);

швидке зростання (пізня, вибухова фаза експоненціального зростання);

вирівнювання (дозрівання нової парадигми).

Частина кривої, в якій ми зараз знаходимось, може заплутати ваше сприйняття того, як швидко все розвивається. На проміжок часу між 1995 і 2007 припав вибух розвитку інтернету, поява в суспільній свідомості Microsoft, Google, Facebook, поява соціальних мереж і поява мобільних телефонів, а потім і смартфонів. Це все було другою фазою — стрибком в зростанні. Період з 2008-го по 2015-й був менш новаторським, хоча б, в технологічному плані. Хтось, думаючи про майбутнє сьогодні, може розглядати тільки останні кілька років для оцінки поточного рівня розвитку і не розглядає картину цілком. По суті, новітня фаза стрибка в зростанні може назрівати знову прямо зараз.

3) Наш власний досвід перетворює нас у впертих старих в питаннях про майбутнє. Наші уявлення про світ ґрунтуються на особистому досвіді. Цей досвід вкорінив в голові уявлення про темпи зростання нещодавного минулого як щось абсолютне. Ми також обмежені нашою уявою, яка спирається на наш досвід при складанні прогнозів на майбутнє. Але дуже часто те, що ми знаємо, не надає нам необхідного інструментарію, який дозволяє вірно мислити про майбутнє (Курцвейл ставить у приклад свій телефон, який в мільйон разів менше, мільйон разів дешевше і в тисячі разів продуктивніше ніж був його комп’ютер в MIT 40 років тому). Тепер лише спробуйте уявити, з якими технологіями ми будемо мати справу в близькому майбутньому. Коли ми чуємо прогнози про майбутнє, які йдуть всупереч з нашими, заснованими на особистих уявленнях про те, як влаштований світ, ми інстинктивно вважаємо, що передбачення наївні. Якби я вам в цьому дописі сказав, що ви, можливо, проживете 150 або 250 років, а може і взагалі не помрете, то ваш інстинкт скаже: «Це маячня, одне я знаю напевно з усієї історії — всі в підсумку помирають». І це вірно, адже ніхто ніколи в минулому не уникнув смерті. Але і літаки не літали, поки їх не винайшли.

Отже, поки ви думаєте про себе «хахах отакої» читаючи цей допис, ви, можливо, даремно сумніваєтесь. Справа в тому, що поки ми бажаємо міркувати по-справжньому логічно і очікуємо, що історична послідовність продовжиться, ми повинні прийти до висновку, що з подальшими десятиліттями зміниться все зміниться набагато більше, ніж ми очікуємо. Логічно також, що якщо найрозвиненіші істоти на планеті продовжать робити все більш високі стрибки в темпах свого розвитку, то в певний момент вони докорінно змінять життя і власне сприйняття себе як людей. Подібно до того, як еволюція робила великі скачки на шляху до розумних істот, поки в кінцевому результаті не зробила такий великий стрибок до хомо сапієнса (людини розумної), який повністю змінив життя на Землі. Якщо ви стежите за тим, що відбувається у світі науки і технологій сьогодні, то ви почнете помічати безліч речей, які вказують на те, що звичний життєвий плин подій, можливо, не витримає наступний стрибок.

Дорога до Суперінтеллекту

Що таке штучний інтелект (Artificial intelligence, далі AI)?

Якщо ви схожі на мене, то для вас штучний інтелект — це вигадка зі світу фантастики, і ви не зовсім розумієте сутність, коли чуєте, як це обговорюють серйозні науковці.

Є кілька причин, через які людей бентежить термін AI.

1) Ми асоціюємо його з фільмами. Зоряні Війни, Термінатор, Космічна одіссея-2001 з вигаданими персонажами — роботами, які змушують нас думати про AI як про певну художню вигадку.

2) AI — дуже широка тема. Він може бути представлений як у вигляді калькуляторів, так і у вигляді автомобілів з автопілотом або навіть чогось, що в майбутньому сильно змінить наше життя. AI належить до всіх цих речей, що і викликає плутанину.

3) Ми користуємося ним у повсякденному житті, не усвідомлюючи того, що це штучний інтелект. Джон Маккарті, який запропонував термін “штучний інтелект” в 1956 році, скаржився: “Варто йому дійсно запрацювати, як усі відразу перестають називати його AI.” Через цей феномен термін звучить більше як щось зі світу фантастики. У той час це звучить і як популярна концепція, яка так і не була реалізована. Курцвейл розповідав, що часто чує, як люди кажуть, що ідея AI втратила себе ще в 80-х, таких людей він порівнює з тими, хто стверджує, що інтернет помер з бульбашкою доткомів.

Отже, пропоную виділити наступне. Насамперед, перестаньте думати про роботів. Робот — це всього лише оболонка AI, яка іноді наслідує людський образ, але AI — це лише комп’ютер усередині робота. AI — це мозок, а робот — це тіло, якщо воно взагалі є. Наприклад, помічник в iOS Siri (яка, до речі, скоро буде розмовляти українською) — це AI, а жіночий голос — це персоніфікація AI, і при цьому немає ніякого робота.

По-друге, ви напевно чули термін «сингулярність» або «технологічна сингулярність». Цей термін використовується в математиці, щоб описати ситуацію, при якій звичайні закони вже не діють. У фізиці він використовується для того, щоб описати феномени, на кшталт, чорної діри або стану, в якому перебував Всесвіт до Великого Вибуху. У 1993-му році Вернор Віндж використовував цей термін у своєму знаменитому есе, щоб описати поворотний момент в історії, коли штучний інтелект перевершить людський, тобто життя зміниться, і звичайні правила будуть неактуальні. Рей Курцвейл пізніше ще трохи все заплутав, визначивши сингулярність як момент, коли прискорена віддача досягає такого піку, при якому технологічний прогрес розпочне відбуватись в нескінченному темпі, після чого ми будемо жити в зовсім іншому світі. Як я помітив, сьогоднішні дослідники AI не особливо вдаються до цього терміну, в будь-якому випадку він всіх заплутує, отже я не буду посилатись на нього тут занадто часто (хоча ми зосередимо нашу увагу на цій ідеї протягом усього тексту).

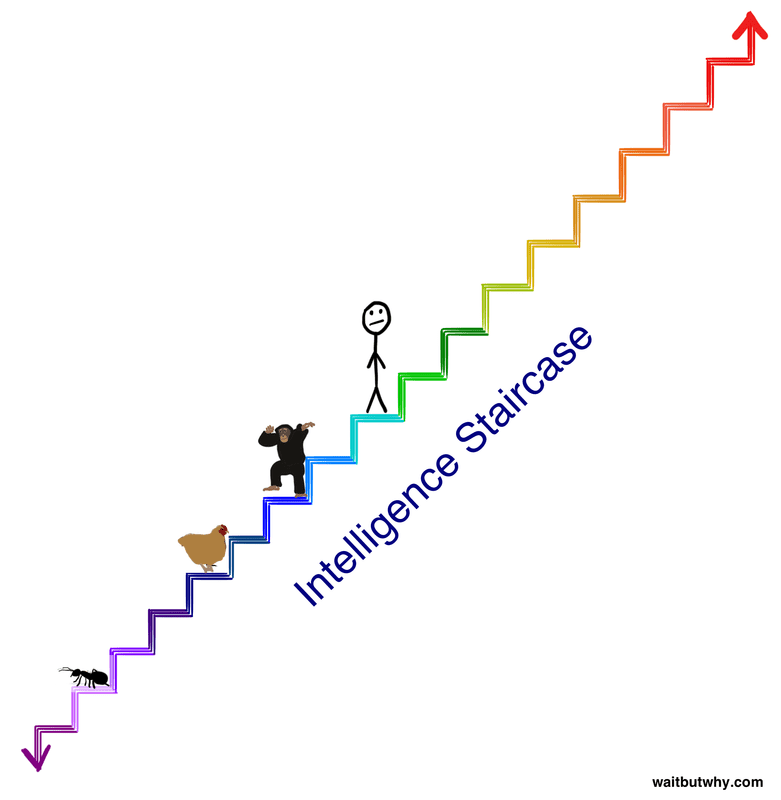

Нарешті, існує безліч різних видів і форм AI, і, як ми вже вирішили — це в цілому дуже широке поняття. Критичні категорії, якими нам слід мислити в питаннях AI, можна розділити на три основні рівні:

1) Слабкий Штучний Інтелект (ANI — Artificial Narrow Intelligence) — це такий AI, який спеціалізується в одній області. Є AI, здатний перемогти в чемпіонаті світу з шахів, але це все, що він вміє. Накажіть йому організувати інформацію на жорсткому диску зручним способом, і він подивиться на вас порожнім 1010101-поглядом.

2) Сильний Штучний Інтелект (AGI — Artificial General Intelligence), також відомий як AI людського рівня, — це комп’ютер, здатний вирішити будь-яку розумове завдання, яке здатна вирішити людина. AGI створити набагато складніше, ніж ANI, і нам це ще тільки потрібно зробити. Професор Лінда Готтфредсон описує інтелект як «дуже загальну психічну здатність, яка, крім усього іншого, включає в себе здатність міркувати, планувати, вирішувати проблеми, мислити абстрактно, розуміти складні ідеї, швидко вчитись і вчитися на досвіді» AGI буде справлятися з усім цим з такою ж легкістю, як і ви.

3) Штучний Суперінтелект (ASI — Artificial Superintelligence). Оксфордський філософ і провідний мислитель у сфері AI Нік Бостром визначає ASI як «інтелект, який набагато розумніший найкращих людських розумів практично в будь-якій сфері, в тому числі в науковій творчості та соціальних навичках». ASI, в свою чергу, уособлюється від комп’ютерів, які трохи розумніші людини, до тих, які перевищують можливості людського розуму в усіх напрямках в трильйони разів. ASI — саме та причина через яку AI настільки гостра тема, що в цьому дописі скоро ви побачите такі слова як «аморальність» і «вимирання».

На сьогоднішній день люди підкорили AI тільки найдрібного калібру, ANI, і тепер вони всюди. Революція Штучного Інтелекту — це шлях від ANI через AGI до ASI. Дорога, яку ми подужаємо і переживемо, а може і ні, але в будь-якому випадку вона змінить абсолютно все.

Пропоную уважно подивитись на те, яким бачать цей шлях провідні мислителі в цій сфері і чому ця революція може статися набагато раніше, ніж ви могли б собі уявити:

Зараз увесь світ працює на ANI

ANI, слабкий AI — це такий штучний інтелект, який дорівнює або перевищує людський інтелект або продуктивність тільки в одній конкретній сфері діяльності.

Ось кілька прикладів:

Автомобілі облаштовані системами ANI — від комп’ютера, який прораховує, коли включати антиблокувальну гальмівну систему, до комп’ютерів, які налаштовують параметри системи впрскування палива. Автомобілі з автопілотом від Google та Tesla, які вже їздять дорогами, містять потужні ANI системи, які дозволять автомобілю розуміти, що відбувається навколо нього і вчасно реагувати.

Ваш смартфон — це невелика фабрика ANI. Коли ви використовуєте навігацію, визначаєте автора пісні за допомогою Shazam або перевіряєте погоду на завтра, розмовляєте з Siri або робите десятки інших операцій, ви використовуєте ANI.

Спам-фільтр у вашому сервісі з електронної пошти — класичний тип ANI, він розпочинає роботу з попередньо запрограмованою можливістю розпізнавати спам і потім самонавчається і адаптує свій інтелект під ваші конкретні вподобання.

Коли ви шукаєте товар на Amazon, а потім цей товар вам рекомендують на зовсім іншому сайті. Або коли Facebook розуміє, кого варто радити для додавання в друзі. Це велика мережа ANI-систем, які працюють разом, щоб зібрати необхідну інформацію про вас і вирішити, що вам показувати в подальшому. Так само на сайтах працює функція «Люди, які придбали цей товар, також купили це», щоб підвищувати продажі і змушувати вас купувати більше.

Google-перекладач — ще один класичний ANI, який дуже добре виконує всього одне завдання. Розпізнавання голосу — це вже інше ANI, але багато програм використовують їх разом, що дозволяє вам вимовити ціле речення, і ваш телефон відтворює його вже на іншій мові.

Коли ваш літак сідає, то не людина вибирає вихід на посадку, і не людина визначає вартість вашого квитка.

Найкращі в світі гравці в шахи, шашки, нарди та ін., тепер ANI-системи.

Пошук Google — це величезна ANI зі складними методами відбору порядку сторінок, яка вирішує, що вам показувати за вашим запитом в першу чергу.

І все це тільки зі сфери споживання, ANI-системи широко застосовуються у військовій техніці, виробництві та фінансах (алгоритмічні високочастотні AI-трейдери продають більше половини пакетів акцій на ринках США). Існують експертні системи, які допомагають лікарям ставити вірні діагнози. Згадайте Ватсона від IBM, який містив достатню кількість фактів і добре розумів мову Алекса Требека (телеведучого), що обіграв всіх чемпіонів Своєї Гри (Jeopardy champions).

Сучасні ANI-системи не такі вже й страшні. У найгіршому випадку глючний або погано запрограмованим ANI може викликати локальну катастрофу, наприклад, відключення енергосистем на атомній електростанції або спровокувати обвалення ринку (згадайте Чорний вівторок, 6 травня 2010 року, коли ANI неправильно відреагувала на несподівану ситуацію, що призвела до різкого обвалу біржового ринку).

Поки ANI ще не складають загрози нашому існуванню, нам слід зрозуміти всю цю велику і складну систему щодо нешкідливих комп’ютерів, через те, що вони віщують насування урагану, який повністю змінить світ. Кожна окрема інновація ANI закладає нову цеглинку на шляху ASI. Аарон Саєнз порівнює роль систем ANI в сучасному світі з «амінокислотам в первинному бульйоні Землі», матеріалом, який в кінцевому підсумку привів до виникнення живої клітини.

Дорога від слабкого штучного інтелекту до суперінтелекту

Чому вона так важка

Ніщо не змусить вас цінувати людський розум більше, ніж усвідомлення того, наскільки складно створити комп’ютер, який був би так само розумний, як і ми. Будівництво хмарочосів, запуск космічних ракет, пояснення Великого Вибуху не такі складні, як вивчення роботи нашого мозку і створення чогось настільки ж крутого. В наш час людський мозок є найскладнішим об’єктом з відомих нам у всьому Всесвіті.

Кумедно, що справжні труднощі при створенні супер штучного інтелекту (AGI) дуже сильно відрізняються від тих, що приходять нам на думку в першу чергу. Розробити комп’ютер, який може помножити два десятизначних числа за секунду, неймовірно легко. Куди складніше розробити комп’ютер, який, подивившись на собаку, зміг би визначити, що це не кішка. Розробити AI, здатний виграти у будь-якої людини в шахи? Так простіше простого. Розробити AI, який буде здатний прочитати речення під картинкою в книжці для п’ятирічних дітей, при цьому не просто розпізнати слова, але і зрозуміти їх зміст — куди складніше. Google зараз витрачає мільярди доларів, щоб зробити щось подібне. Важкі речі на зразок стратегій фінансових ринків, статистичних обчислень і перекладів на інші мови дуже легко даються комп’ютерам, тоді як прості речі на зразок зору, руху і сприйняття надскладні для них. Як одного разу сказав учений Дональд Кнут: “AI досягли чималих успіхів у всьому, що вимагає мислення, але не можуть зробити більшу частину того, що люди і тварини роблять не замислюючись”.

До нас швидко приходить усвідомлення того, що речі, які здаються нам простими, насправді неймовірно складні. Вони здаються нам легким тільки, тому що ці навички розвинула в нас еволюція за сотні мільйонів років. Коли ти простягаєш руку до предмета, то м’язи, сухожилля і кістки в твоєму плечі, лікті і зап’ястку в поєднанні з очима миттєво виконують довгу серію операцій, щоб дозволити вашій руці зробити прямий рух крізь три виміри. Це здається легким тільки тому, що ви ідеально налагодили програмне забезпечення в вашому мозку для цього завдання. За таким же принципом можна сказати, що не шкідливі програми дурні, якщо не можуть обійти різноманітні капчі, які вам доводиться вводити для реєстрації на новому сайті, а навпаки, ваш мозок настільки розумний, що може легко з ними впоратися.

З іншого боку, множення великих чисел і гра в шахи — це нові завдання для біологічних істот, у нас просто не було достатньо часу, щоб розвинути навички для них, тому комп’ютер так легко нас в цьому обходить. Подумайте, що б ви зробили — програму, яка може множити величезні числа або ту, яка розуміла б сутність букви “Ї” досить добре, щоб вміти розпізнати її в мільйонах варіацій шрифтів і почерків.

Ось один кумедний приклад — коли ви дивитесь на це зображення, і ви, і комп’ютер легко розумієте, що перед вами прямокутник в двох по черзі відтінках:

Поки нічия. Але якщо ви приберете чорний колір і розкриєте все зображення…

…У вас не виникне проблем з описом напівпрозорих циліндрів і тривимірних кутів, але комп’ютер тут з тріском провалиться. Він би описав те, що бачить, як різноманітність різних двомірних форм в декількох відтінках, що там по суті і зображено. Ваш мозок виконує купу неперевершеної роботи для того, щоб розтлумачити побачену глибину, поєднання відтінків, просторове освітлення, які зображено на картинці. На фотографії знизу комп’ютер бачить двомірний колаж з чорного і білого, в той час як вам відразу зрозуміло, що на ній зображений чорний камінь:

І все, що ми щойно згадали, стосується тільки сприйняття та обробки статичної інформації. Щоб бути розумним, як людина, комп’ютеру потрібно зчитувати і розуміти різницю між виразами облич, бачити відмінності між відчуттями достатку, полегшення, задоволення і радості, і розуміти, чому «Хоробре серце» хороший фільм, а будь-який фільм Уве Болла — жахливий. Ну, майже будь-який, правда.

Моторошно.

Так як же нам з цим впоратися?

Перший крок на шляху до створення AGI (сильного AI) — збільшення обчислювальних потужностей.

Для того, щоб створення AGI стало можливим, безумовно, повинна відбутися одна річ — збільшення потужності комп’ютерної техніки. Щоб система AGI була такою розумною, як людський мозок, їй потрібно зрівнятися з обчислювальною потужністю мозку.

Один із способів вираження цієї здатності мозку — сума обчислень в секунду (Герц) які може зробити мозок. Щоб обчислити задачу, потрібно визначити максимальну частоту герц окремо в кожній зоні головного мозку і потім скласти їх.

Рей Курцвейл знайшов швидший спосіб обчислити це загальне значення. Він пропонує вимірювати частоту герц окремої зони мозку і вагу цієї ділянки і помножити результат пропорційно вазі всього мозку. Звучить трохи сумнівно, але він робив це безліч разів, вимірював окремі зони мозку і загальна кількість завжди показувала приблизно один і той же рузультат — близько 10 в 16-й степені, 10 квадрильйонів герц.

В даний час найшвидший супер-комп’ютер у світі, китайський Тяньхе-2, перевищив цей результат з тактовою частотою близько 34 квадрильйонів Гц. Але ця залізяка займає площу в 720 квадратних метрів, споживає 24 мегават електроенергії, в той час як людський мозок всього 20 Ватт, та й коштують мізки не 390 мільйонів доларів. Погодьтеся, він не особливо підходить для широкого застосування, та й для більшості сфер промислового виробництва.

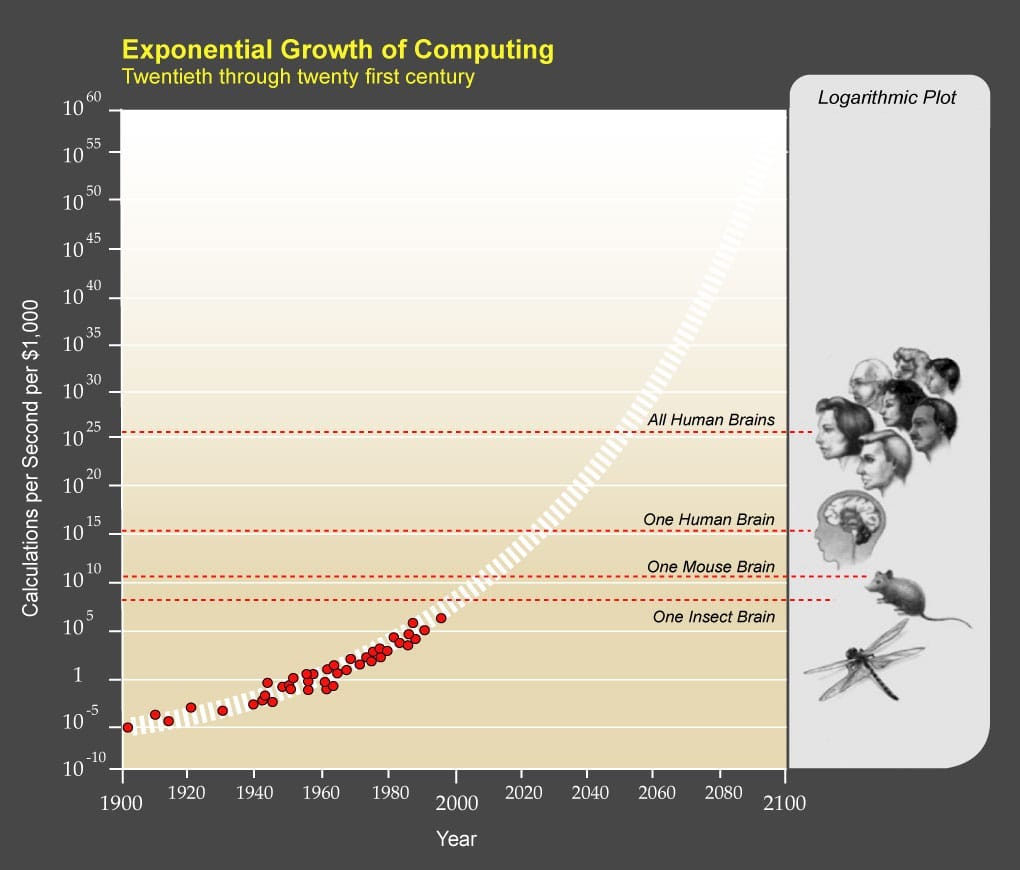

Курцвейл пропонує розглядати комп’ютери з розрахунку рівень потужності, доступний за 1000 доларів. Як тільки цей рівень досягне людського — 10 квадрильйонів герц, тоді це буде означати, що AGI можуть стати реальною частиною нашого повсякденного життя. Закон Мура — історично надійне правило, згідно з яким максимальна обчислювальна потужність в світі подвоюється приблизно кожні 2 роки, тобто розвиток комп’ютерних технологій, як і розвиток людства, зростає в геометричній прогресії. Розберемося, що мав на увазі Курцвейл, говорячи про тисячу доларів за допомогою цієї таблиці:

Комп’ютери, які зараз коштують 1000 доларів, за своєю потужністю дорівнюють мозку миші і в тисячу разів менше людського. Це не виглядає чимось серйозним, до тих пір поки ви не згадаєте, що така комп’ютерна потужність становила трильйонну від рівня мозку в 1985 році, в 1995 мільярдну і мільйонну в 2005. Тобто на даному етапі ми можемо очікувати, що до 2025 року ми зможемо дозволити собі комп’ютер, що конкурує з мозком.

У плані заліза і обладнання, енергія, необхідна для AGI, технічно вже доступна зараз в Китаї і стане загальнодоступною через якісь 10 років. Але така безпорадна обчислювальна потужність сама по собі не робить комп’ютер розумніший, так що наступне питання — як привнести людський інтелект у всю це потужність?

Другий крок до AGI (сильному AI) — зробити його розумним.

Досить неприємна частина. Правда полягає в тому, що ніхто насправді не знає, як зробити його розумним. Ми до сих пір міркуємо, як змусити комп’ютер відрізняти собаку від кішки, розпізнавати дивно написану букву Й і розуміти, що кіно не дуже. Існує купа кмітливих стратегій, і в кінцевому підсумку якась із них виявиться дієвою. Тут я пропоную 3 найпопулярніших підходи:

1) Плагіат мозку

Якщо б науковці скаженіли від того, що у сусіда по парті виходить писати усі контрольні на п’ять, а у них при всьому бажанні це і близько не виходить. Врешті-решт вони вирішують: «Гаразд, плювати, ми просто спишемо у нього всі відповіді». І це не позбавлено сенсу, ми побиваємось, щоб створити досконалий комп’ютер, тоді як в голові у нас є ідеальний прототип для нього.

Науковий світ працює над зворотним конструюванням мозку, щоб зрозуміти, як еволюції вдалося зробити таку круту річ. За оптимістичними прогнозами, роботу завершать до 2030 року. Після того, як це станеться, ми відкриємо всі секрети нашого мозку і зможемо, захоплено вкрасти всі його інновації. Штучна нейронна мережа є яскравим прикладом комп’ютерної архітектури, яка імітує мозок. Вона являє собою мережу транзисторів — «нейронів», з’єднаних між собою, але спочатку їй нічого не відомо, подібно мозку немовляти. Спосіб, за яким вона «вчиться», полягає в тому, що спочатку вона намагається виконати завдання, наприклад, розпізнати почерк, спочатку нейронні імпульси і здогадки в розшифровці кожної окремої букви будуть абсолютно випадковими. Але коли їй скажуть, що вона зробила це вірно, з’єднання транзисторів в послідовності, яка допомогла знайти правильне рішення, стануть міцнішими, якщо ж навпаки, відповідь буде невірним, вони ослабнуть. Після довгого процесу таких випадкових спроб і їх оцінки, мережа, сама по собі, формує «розумні» нервові шляхи і машина стає оптимізованою для виконання цього завдання. Мозок вчиться подібним, але більш складним чином. З продовженням досліджень мозку нам відкриваються все нові способи використання нейронної системи.

Більш кардинальний плагіат включає в себе стратегію, яку можна було б назвати «емуляція всього мозку». Для цього потрібно розрізати реальний мозок на мікрошари, відсканувати кожен, використовувати програмне забезпечення, щоб зібрати точну реконструйовану 3D-модель і потім реалізувати її в потужному комп’ютері. В такому випадку у нас з’явився б комп’ютер, здатний на все те, на що здатний і людський мозок. При гарній вдачі вченим вдалося б емулювати реальний мозок з такою точністю, що особистість і пам’ять людини, якій належав мозок, залишилися б недоторканими при завантаженні архітектури мозку на комп’ютер. Умовно кажучи, мозок належав Джиму, після смерті його сканували і завантажили на комп’ютер, який прокинувся б Джимом. Тобто Джим став би надійним AI людського рівня, і ми змогли б тепер перетворити його в супер AI, і не вважаю, що той був би проти.

Наскільки ми далекі від досягнення повної емуляції мозку? Нещодавно нам вдалося емулювати міліметровий мозок хробака, в якому всього 302 нейрони. У людському мозку їх близько 100 мільярдів. Якщо після цього вам здасться, що проект приречений, то згадайте потужність експоненціального прогресу. Спочатку ми підкорили мозок хробака, потім піде мурашиний, за ним мозок миші і, бачте, все це здасться більш реальним.

2) Спробувати змусити еволюцію зробити те, що вона вже зробила

Якщо ми вирішимо, що контрольну сусіда по парті списати дуже важко, ми можемо спробувати підготуватися до неї по його методу. Ось що нам відомо. Зібрати комп’ютер за потужністю рівному нашому мозку — можливо, еволюція нашого мозку є тому підтвердженням. І якщо мозок виявиться занадто складним для того, щоб його емулювати, ми можемо відтворити натомість процес його еволюції. Намагатися відтворити мозок — це як побудувати літак, скопіювавши розмах пташиного крила — частіше всього машини краще конструювати за допомогою орієнтованого на них підходу, а не наслідуючи біологію в точності.

Таким чином, щоб побудувати AGI ми можемо імітувати процес еволюції. Існує метод під назвою «генетичні алгоритми», який працює в такий спосіб: є процес продуктивності-і-оцінки, який повторюється знову і знову (таким же чином, як біологічні істоти «продуктивні», тобто живі і «оцінюються» за тим, чи здатні вони до розмноження чи ні). Кілька комп’ютерів намагаються виконувати завдання, і найуспішніші з них будуть схрещуватись один з одним шляхом впровадження половини ПЗ кожного з них в новий комп’ютер. Менш успішні комп’ютери будуть знищуватись. Через безліч таких повторів, природний відбір буде виробляти комп’ютери все краще і краще. Складність полягатиме в створенні автоматизованого циклу розмноження таким чином, щоб процес еволюції йшов сам по собі.

Недолік копіювання еволюції полягає в тому, що еволюція любить займати мільярди років, а ми хочемо з цим впоратись за кілька десятиліть.

Але у нас є багато переваг перед еволюцією. По-перше, еволюція не передбачає результати і працює випадковим чином, вона виробляє більше безкорисних мутацій, ніж корисних, але якщо ми будемо її контролювати, вона стане глючити на користь нам. По-друге, еволюція не прямує ні до чого, в тому числі і до інтелекту, іноді навколишнє середовище може навіть здійснювати відбір проти розвитку розуму (так як він вимагає багато енергії). Ми, навпаки, могли б спеціально направити цей еволюційний процес в бік розвитку інтелекту. По-третє, щоб відбір був на користь інтелекту, еволюції доведеться змінитись в купі інших аспектів — наприклад, переналаштувати спосіб, яким клітини виробляють енергію, адже ми можемо компенсувати ці навантаження, використовуючи електрику. Це все зайняло б набагато менше часу, ніж природний процес еволюції, але все одно неясно, чи допоможе нам це досягти необхідних поліпшень і чи життєздатна ця стратегія.

3) Скинути всю цю проблему на самі комп’ютери

Коли вчені остаточно впадуть у відчай, вони спробують зробити так, щоб контрольна сама себе написала. Проте це один з найбільш вірогідних методів з усіх. Ідея полягає в тому, що ми розробимо комп’ютер, який буде проводити дослідження з AI і програмувати зміни у власній архітектурі, що дозволить йому не тільки вивчати, але і вдосконалити себе. Тобто самі комп’ютери стали б вченими в області комп’ютерів для того, щоб займатися власним розвитком. Їх основне завдання — з’ясувати, як зробити себе розумнішими. Детальніше про це пізніше.

Все це може статися дуже скоро.

Швидкий розвиток заліза та інноваційні експерименти з програмним забезпеченням відбуваються одночасно, і AGI може підкрастися до нас швидко і несподівано з двох основних причин:

- При експоненціальному зростанні швидкість равлика може різко зрости. Гіфка наочно це пояснює:

- Коли мова йде про програмне забезпечення, прогрес може здаватися повільним, але досить одного відкриття для миттєвого стрибка в розвитку (коли ми вважали всесвіт геоцентричним, всі обчислення давались нам з силою, але одразу як ми зрозуміли, що всесвіт геліоцентричний, все стало відразу набагато простіше). Або коли справа доходить до самовдосконалення комп’ютера, нам може здатись, що ми далекі від мети, але якесь чергове автооновлення може різко наблизити комп’ютер до рівня людського інтелекту.

Дорога від AGI (сильного AI) до ASI (суперінтеллекту)

В певний момент ми спорудили AGI-комп’ютери з людським рівнем загального інтелекту. Що далі? Просто купа людей і комп’ютерів, які живуть разом у рівності.

Як би ж то так!

Справа в тому, що AGI буде як і раніше мати значні переваги в порівнянні з людьми:

Залізо:

Швидкість.

Нейрони мозку не перевищують 200 Гц, в той час як сьогоднішні мікропроцесори (які набагато повільніше, ніж ті, що будуть, коли з’явиться сильний AI) працюють з частотою 2 ГГц або в 10 мільйонів разів швидше наших нейронів. Швидкість внутрішньої комунікації людського мозку, що досягає 120 м/с, жахливо відстає від швидкості комп’ютера, яка може досягти швидкості світла.

Розмір і зберігання.

Мозок обмежений в розмірі формою наших черепів і не може стати набагато більше, і навіть якщо стане, швидкість внутрішньої комунікації не буде достатньою. Комп’ютери можуть збільшуватися до будь-якого фізичного розміру, що дозволяє запхати в них набагато більше заліза, комп’ютери зі збільшеним об’ємом оперативної пам’яті (ОЗУ) і довгостроковій пам’яті (жорсткий диск) володіють величезними можливостями і працюють точніше, ніж наша власна пам’ять.

Надійність і довговічність.

Не тільки пам’ять комп’ютера буде точнішою, але і комп’ютерні транзистори. На відміну від біологічних нейронів, вони менше зношуються і можуть бути легко відремонтовані або замінені.

Людський мозок також швидше втомлюється, в той час як комп’ютери можуть працювати без зупинок, при піковій завантаженності 24 години на добу і 7 днів на тиждень.

Програмне забезпечення:

Можливість редагування, можливість модернізації, і в цілому взагалі найширші можливості.

На відміну від людського мозку, комп’ютерна програма може оновлюватися і виправляти помилки, з нею легко експериментувати. Оновлення ПЗ можуть охоплювати області, в яких людський мозок слабкий. Програмне забезпечення людського зору унікальне, але здатність до його вдосконалення досить низька. Комп’ютери можуть зрівнятися з людиною за рівнем програмного забезпечення, що відповідає за зорову функцію, але воно також може стати більш оптимізованим і поліпшуватися.

Колективна здатність.

Люди перевершують всі інші біологічні види в колективній роботі. Починаючи з розвитку мови і формування великих громад, з подальшим винаходом письма і друку, а тепер і інтернету або майнкрафту, гітхабу. Колективний розум людства є однією з основних причин, чому ми змогли так далеко відірватися від всіх інших видів. Але комп’ютери обходять нас і в цьому. Всесвітня мережа AI зможе моментально синхронізувати всі дані між окремими комп’ютерами. Так що якщо один комп’ютер дізнається щось, ця інформація миттєво завантажується на всі інші комп’ютери. Група комп’ютерів може взяти на себе одну задачу і впоратися з нею як єдине ціле, тому що на відміну від людей, вони не стануть сперечатися між собою, захищаючи свої думки, у них немає мотивацій і особистої зацікавленості, як у нас.

AI, який стане сильним (AGI) за допомогою запрограмованого самовдосконалення, не сприйме досягнення рівня людського інтелекту, як якийсь поворотний момент. Тільки для нас це важливий показник, отже, AGI не стане на ньому зупинятись. А з огляду на ті переваги, якими буде володіти AGI з інтелектом, еквівалентним людському, досить очевидно, що на цьому рівні він буде залишатися недовго і продовжить вдосконалюватись, досягнувши інтелекту, що перевищує людський.

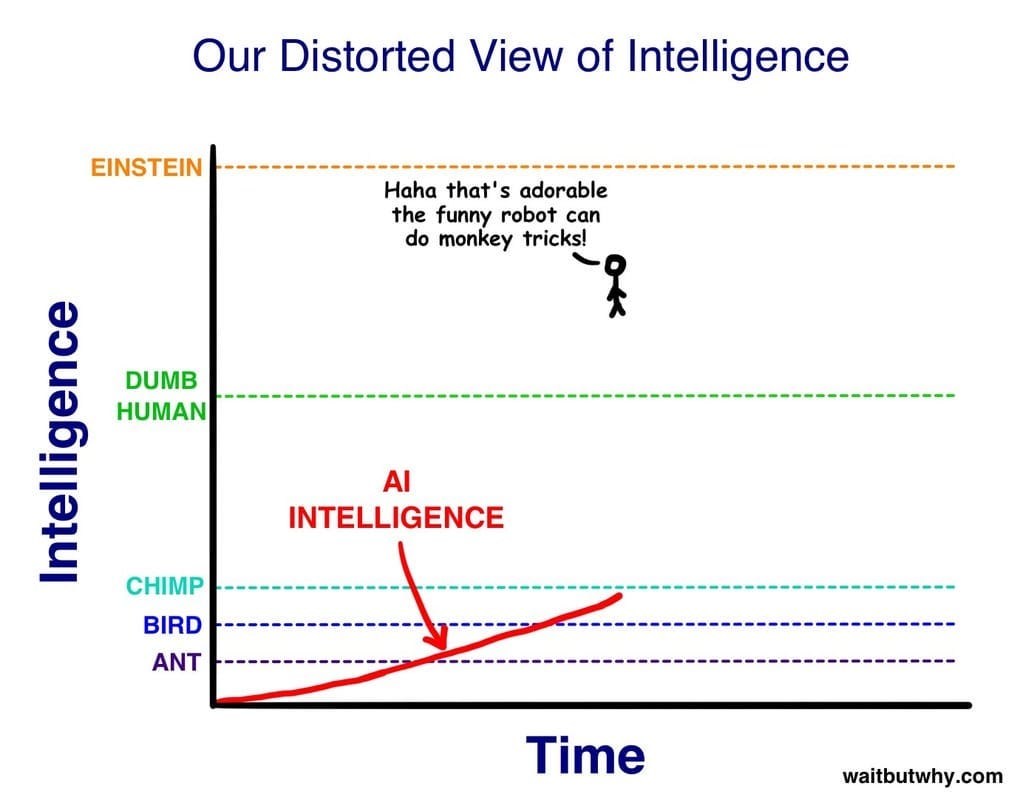

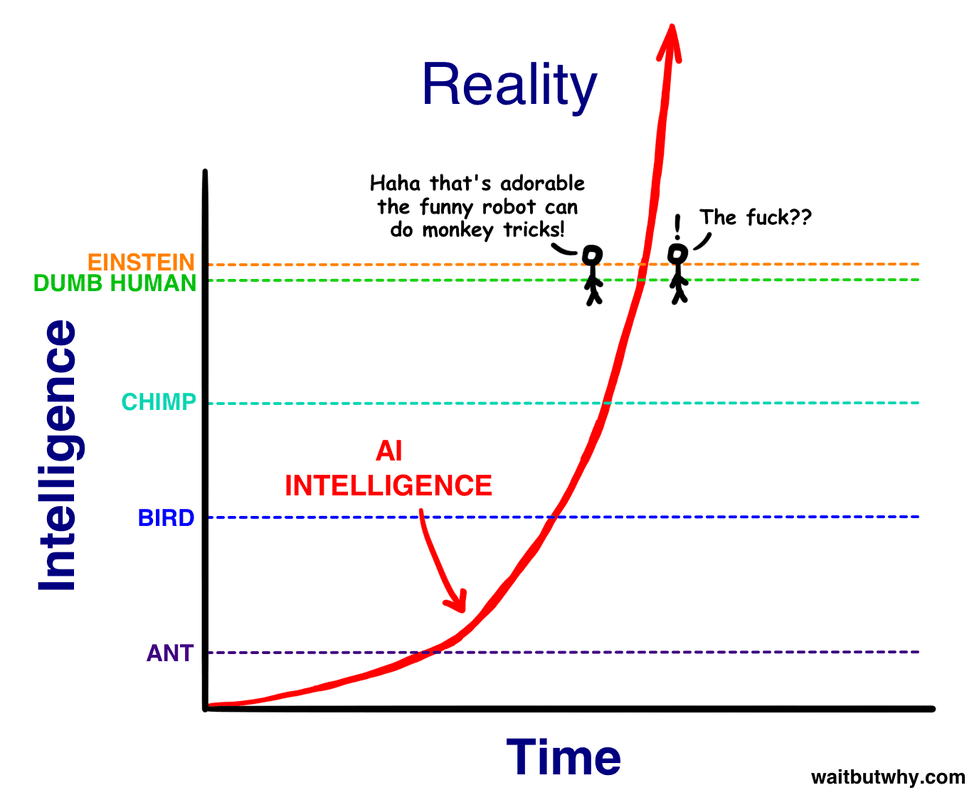

Коли це станеться, ми, швидше за все, будемо в шоці. Адже з нашої точки зору, А — незважаючи на те що інтелект різних тварин відрізняється, в будь-якому випадку він в рази менше розвинений, ніж у нас, Б — найрозумніших людей ми вважаємо такими тільки тому, що порівнюємо їх з не дуже розумними.

Так що коли AI наздожене рівень інтелекту тварин, ми будемо сприймати його як щось, що розумніше тварин. Коли він досягне найпримітивніших здібностей людського інтелекту, ми, як висловився Нік Бостром, будемо сприймати його як «провінційного йолопа» і виглядати наша реакція буде наступним чином — “подивись він як дурник, до чого ж це мило!” Але проблема полягає в тому, що різниця в інтелектуальних здібностях між провінційним йолопом і Ейнштейном лежить в дуже невеликому діапазоні. І AGI швидко наздожене і обжене старого Альберта. І тоді нас осяє:

І що ж далі?

Інтелектуальний вибух

Сподіваюся, ви насолодилися часом, поки все виглядало невинно, тому що з цього моменту вся ця історія з AI почне ставати ненормальною і жахливою. Я хочу попередити, все, що я буду говорити, як і раніше має реальні наукові підтвердження і є прогнозом на майбутнє, який склали високоповажні науковці та мислителі сучасності. Просто пам’ятайте це, поки читаєте.

В будь-якому випадку, як я вже сказав вище, більшість варіантів розвитку подій, за якими ми доберемося до AGI, мають на увазі процес самовдосконалення AI. І як тільки з’явиться AGI, навіть системи, які розроблялися за допомогою методів, що не включали в себе самопрограмування, стануть досить розумними, щоб почати самостійно вносити в свою архітектору зміни, якщо вони цього захочуть.

І ось тут вся концепція починає ставати ще цікавіше. Давайте введемо нове поняття: рекурсивне самовдосконалення. Працює воно наступним чином:

Система AI в якийсь момент, скажімо, на рівні йолопа провінціала, програмується на самовдосконалення. Як тільки це відбувається і вона стає розумнішою, досягаючи рівня Ейнштейна, вона продовжує розвиватися, але вже маючи інтелект Ейнштейна, на що буде потрібно менше часу. По мірі того як того, стрибки в розвитку будуть збільшуватись, AGI досягне рівня ASI — це і називається Інтелектуальним Вибухом і служить остаточним прикладом дії Закону Прискореної Віддачі.

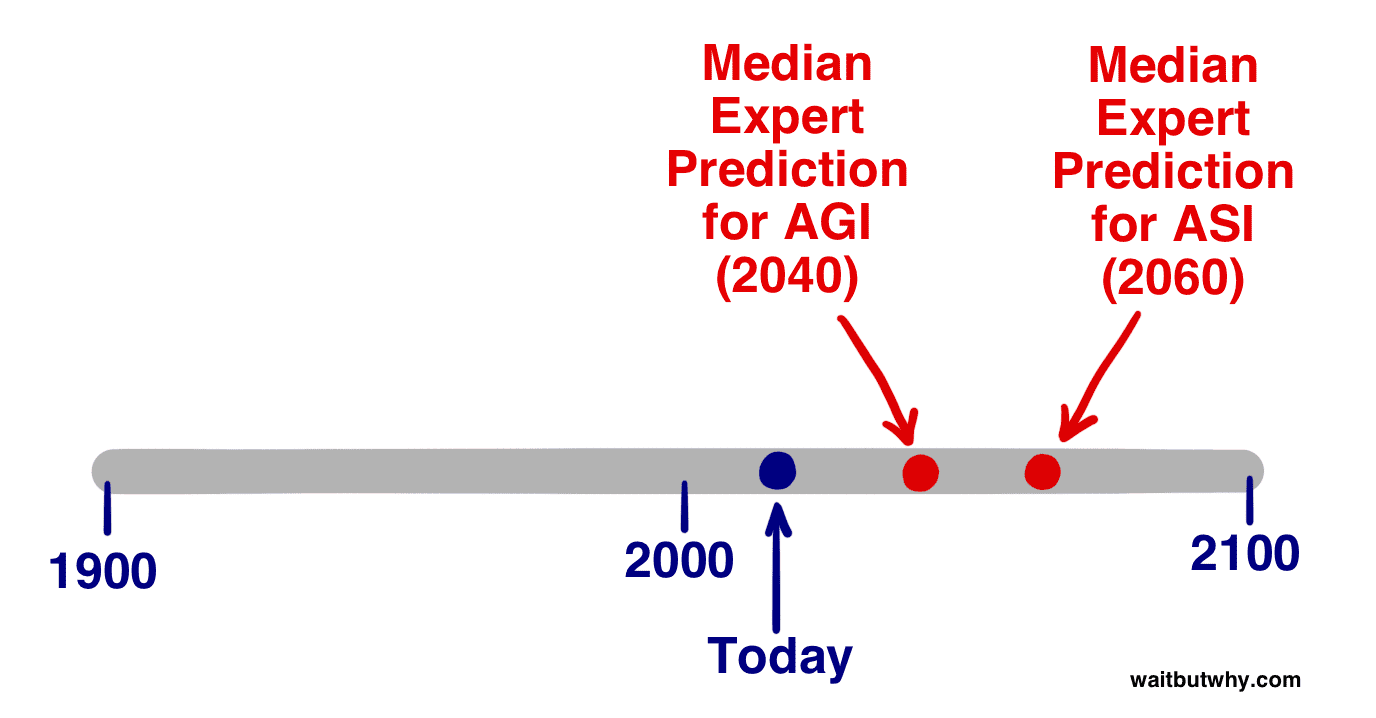

Існують суперечки про те, як скоро AI досягне загального рівня людського інтелекту. За опитуваннями сотень вчених, це, ймовірно, відбудеться до 2040, що всього через 25 років, і це не так вже й далеко.

Але може статися й таке:

Слабкому AI буде потрібно кілька десятиліть, щоб стати AGI з низьким рівнем інтелекту, але в кінцевому підсумку це все одно станеться. Комп’ютер буде здатний розуміти навколишній світ на рівні чотирирічної дитини, але вже через годину він буде розуміти складну теорію фізики, яка об’єднує теорію відносності з теорією квантової механіки, що не вдавалося зробити жодній людині. Ще через півтори години AGI досягає рівня ASI і буде перевищувати інтелект будь-якої людини в 170000 разів або 270000, або яка різниця взагалі.

Суперінтеллект такого масштабу ми навіть приблизно зрозуміти не зможемо. Все одно, що джміль спробує розібратися в Кейнсіанській економіці. В середньому в світі рівень IQ складає 130 балів для розумної людини і 85 для менш розумної, але ми навіть не здатні уявити рівень IQ в 12952.

Точно відомо, що абсолютне домінування людей на Землі передбачає чітке правило — з розумом приходить сила. Це означає, що ASI стане найпотужнішим творінням, які коли-небудь існували на Землі, і це може статися через кілька десятиліть.

Якщо наші мізки були здатні придумати Wi-Fi, то чомусь, що в 100 або 1000 або 1000000000 раз розумніше, від нас, не важко буде контролювати розташування кожного окремого атома у всесвіті.

Все, що ми звикли сприймати як якусь магію, будь-яка сила, яку вважали нами чимось божественним, стане для ASI простою, як вимикання світла. Створення технології зворотного старіння людини, лікування хвороб і голоду, перепрограмування погоди для захисту майбутнього життя на Землі — все це стане можливим. Але також можливим буде і моментальне припинення існування всіх форм життя на Землі.

ASI стане всемогутній Богом на Землі, і найважливішим питанням для нас залишиться тільки наступне:

Чи буде цей Бог добрим?

«Перед нами знаходиться надзвичайно складне завдання і невідомо, скільки часу буде потрібно на його рішення, цілком можливо, від цього залежить доля всього людства» — Нік Бостром

Тепер ви, споглядаючи в екрани моніторів, напевно, гадаєте, які почуття вам слід відчувати, поки ви намагаєтеся переварити цю інформацію. Тим часом, до того, як зануритись у все це з головою, пропоную згадати, що означає для машини володіння суперінтеллектом.

Існує ключова відмінність між швидким суперінтеллектом і якісним суперінтелектом. Часто, коли ми намагаємося уявити суперрозумні комп’ютери, ми в першу чергу уявляємо, що вони так само розумні, як і людина, лише здатні мислити набагато швидше (згадайте х/ф «Вона», швидкість є основною рисою, що відрізняє супер ОС від людини), тобто, суперкомп’ютеру буде потрібно п’ять хвилин, щоб вирішити завдання, на яке у людини піде років з десять.

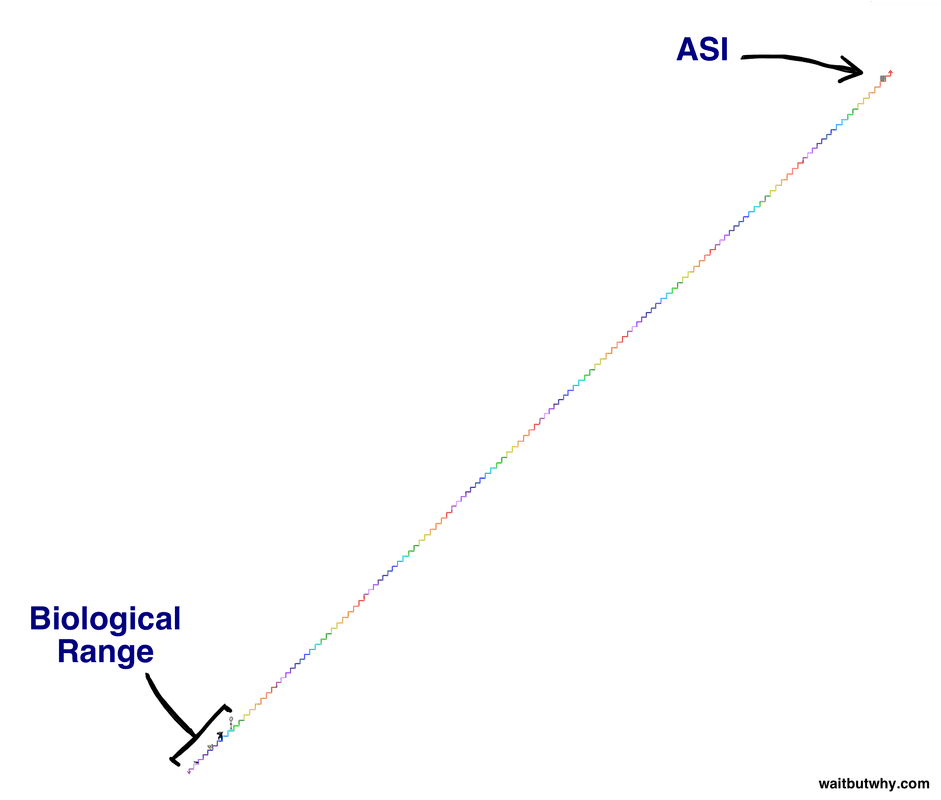

Виглядає вражаюче, і ASI дійсно буде мислити в рази швидше будь-якої людини, але ця відмінність полягатиме в якості цього мислення, а не в його швидкості, що принципово все змінює. Різниця в розумових здібностях між людиною і шимпанзе полягає не в швидкості мислення, а в тому, що людський мозок містить більшу кількість складних когнітивних модулів, які дозволяють нам будувати складні лінгвістичні зв’язки, довгострокові плани або абстрактні міркування, тоді як мозок шимпанзе на це просто не здатний. Прискорення роботи мозку шимпанзе в тисячу разів не принесе такого результату навіть через десятиліття. Шимпанзе як і раніше не буде здатний зібрати хитромудру модель, використовуючи набір спеціальних інструментів, тоді як людина справиться з цим за кілька годин. Існує величезна кількість когнітивних функцій, які ніколи не стануть доступні шимпанзе, незалежно від того, скільки часу у нього піде на спроби.

Проблема не в тому, що шимпанзе не може робити те ж, що під силу нам, а в тому, що шимпанзе навіть не здатний зрозуміти, що такі можливості існують. Шимпанзе може приблизно розуміти, що таке людина і що таке хмарочос, але він ніколи не зрозуміє, що люди побудували хмарочоси. Для шимпанзе все велике є частиною природи і точка, сама можливість побудувати хмарочос лежить поза межами його розуміння. Все це є результатом невеликої відмінності в якості розуму.

Тепер для того, щоб зрозуміти, наскільки важливим буде поява надрозумних комп’ютерів, уявіть, що один з них знаходиться на тих темно-зелених сходах, але на дві сходинки вище, ніж людина. І це буде всього лише злегка супер машина, але різниця в когнітивних здібностях між нею і нами буде такою ж, як і різниця між людиною і шимпанзе. Як і шимпанзе, нездатний зрозуміти хмарочоси, ми ніколи не зможемо зрозуміти щось, що під силу комп’ютеру на темно-зелених сходах, навіть якби він постарався нам це пояснити, не кажучи вже про те, щоб зробити це самим. І він лише на дві сходинки вище від нас. Комп’ютер на передостанній сходинці зверху буде для нас, як ми для мурах, вона може роками намагатися дати нам найпростіше уявлення про те, що їй відомо, але все буде марно.

Але суперінтелект, про який ми говоримо, зараз розташований далеко за межами цих сходів. При інтелектуальному вибуху, чим комп’ютер стає розумнішим, тим швидше він стає здатним вдосконалювати свій інтелект. Машині можуть знадобитись роки, щоб зробити крок і стати хоча б на щабель вище шимпанзе, але потім, можливо, їй знадобиться всього кілька годин, щоб перестрибнути на темно-зелену сходинку, після чого подальші стрибки будуть займати лічені секунди. Тому важливо розуміти, що пройде зовсім небагато часу від моменту, коли ми почуємо новини про створення першого комп’ютера, який можна буде порівняти за інтелектом з людиною, до моменту, коли ми почнемо співіснувати на Землі з комп’ютерами, які будуть на мільйони сходинок вище за нас.

Якщо ми вже домовились, що немає сенсу навіть намагатися зрозуміти машину, яка на дві сходинки вище за нас, пропоную конкретно раз і назавжди домовитись, що немає ні найменшого шансу передбачити, що зробить з нами ASI і якими для нас виявляться наслідки. Кожен хто спробує зробити вигляд, що може це передбачити, явно нічого не розуміє в суперінтелекті.

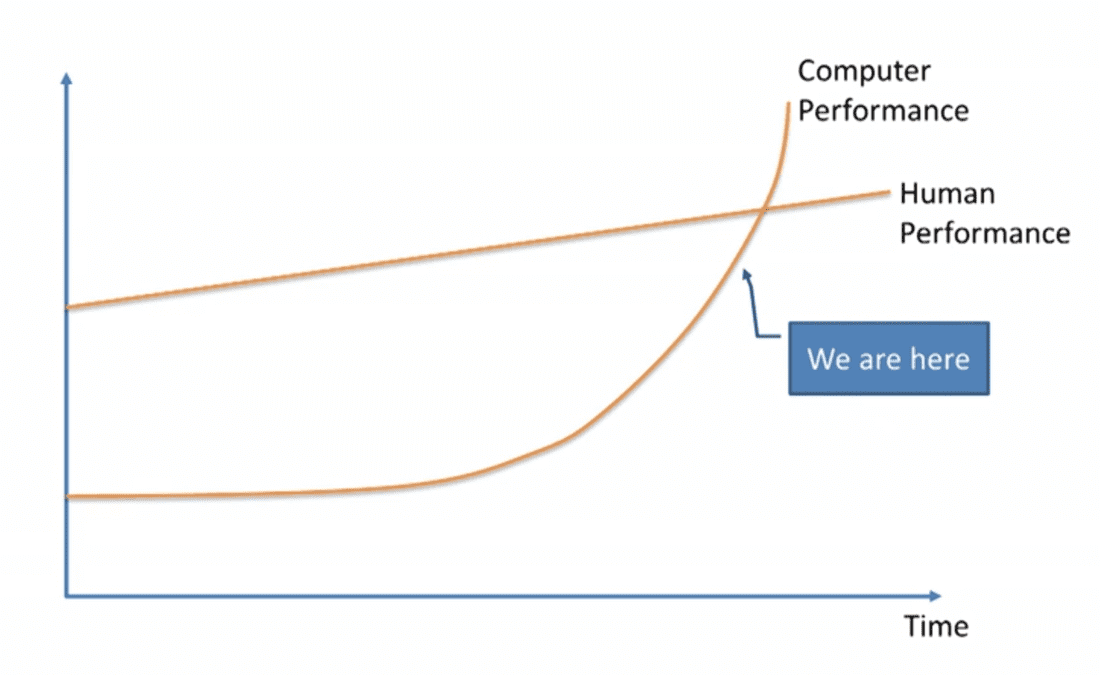

Еволюція удосконалювала біологічний мозок повільно і поступово протягом сотень мільйонів років, і в цьому плані створення людиною суперінтелекту буде великим ляпасом в бік еволюції. Хоча, можливо, це і є частина еволюції — можливо, вона влаштована таким чином, що людський розум розвивається до тих пір, поки він не стає здатний створити штучний суперрозум, що є в певній мірі детонатором який викличе вибух, який визначить майбутнє для всіх живих організмів:

З причин, які ми обговоримо пізніше, велика частина наукового співтовариства вважає, що питання не в тому, чи наступимо ми на цю міну, а коли. Така інформація трохи зносить дах.

І куди це нас приведе?

Ніхто в цьому світі, і вже точно не я, не зможе відповісти вам на це питання. Але Оксфордський професор філософії і провідний дослідник в сфері штучного інтелекту, Нік Бостром вважає, що ми можемо звести всі варіанти розвитку подій в дві широкі категорії.

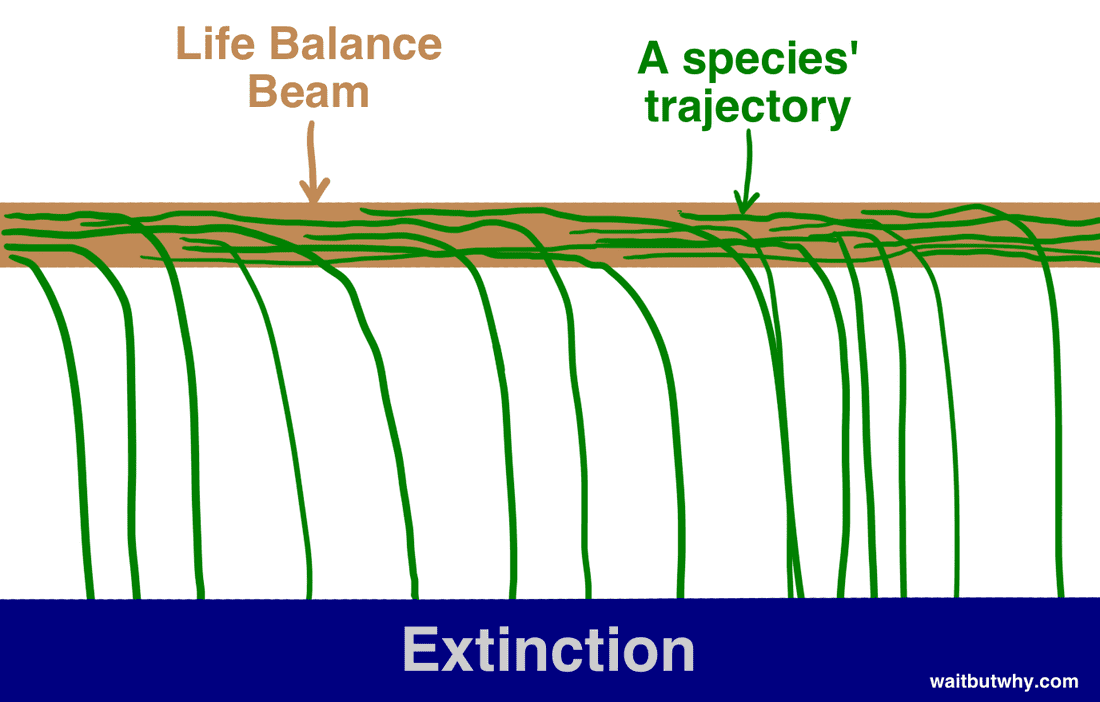

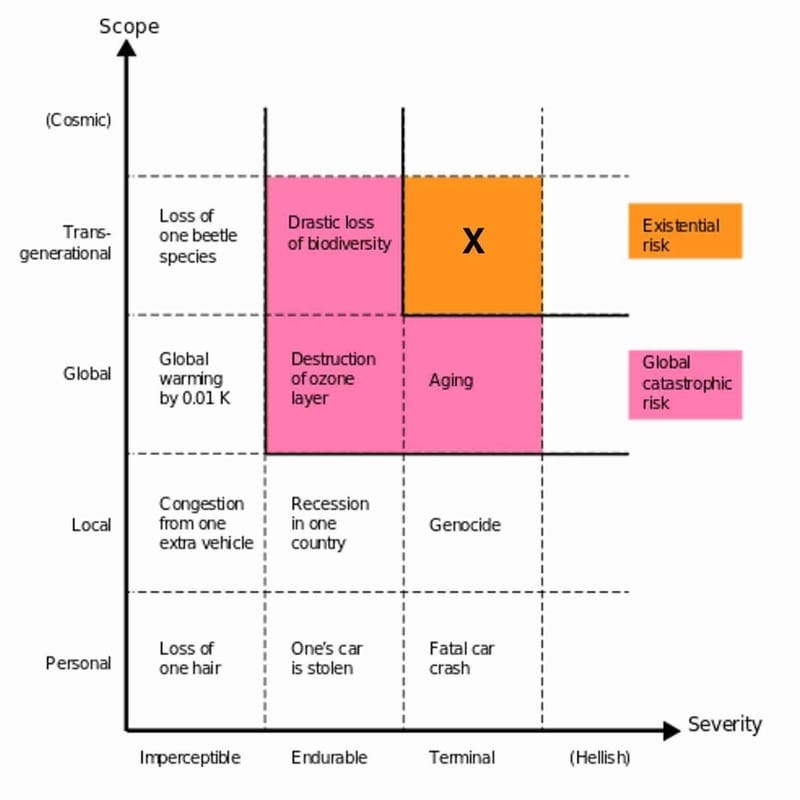

По-перше, якщо подивитись на історію, ми побачимо, що життя влаштоване таким чином: новий вид з’являється, існує якийсь час і потім неминуче втрачає рівновагу і звалюється з колоди життя, опиняючись на межі вимирання:

«Всі види в кінцевому рахунку вимирають» — було майже таким же надійним правилом, як і «всі люди вмирають». Поки що 99,9% живих істот не втримали свою рівновагу і зірвалися з колоди. Перебуваючи на межі вимирання і з останніх сил чіпляючись за цю колоду, вид може бути легко скинутий будь-яким катаклізмом або появою нового виду. Нік Бостром називає вимирання аттрактором — станом, в який потрапляють усі істоти і ніколи з нього не повертаються назад.

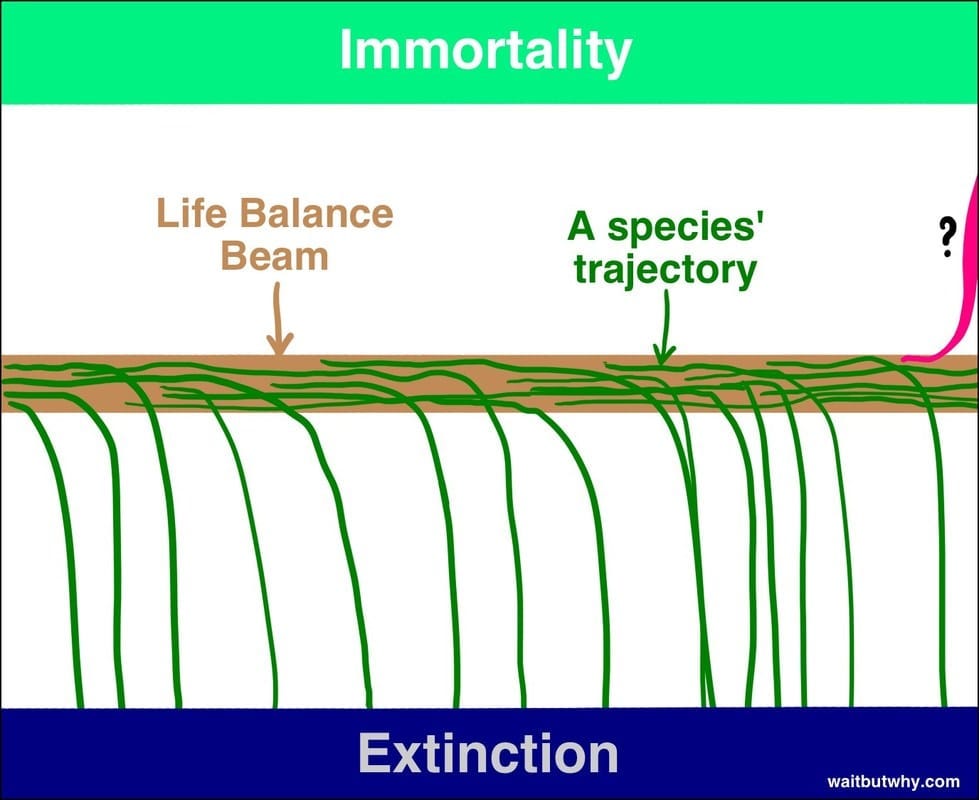

Хоча більшість вчених, з роботами яких я стикався, вважають, що поява ASI прирече людство на вимирання, багато хто все ж вірять, що при грамотному використанні ASI може привести окремих людей або весь людський рід до другого стану аттрактора — безсмертя виду.

Бостром переконаний, що безсмертя виду, як і його вимирання, являє собою стан аттрактора. Як тільки ми досягнемо його, ми назавжди переможемо смерть. Таким чином, незважаючи на те, що всі види досі скочувались в сторону межі вимирання, Бостром вважає, що у колоди є два краї і ніхто на Землі ще не був досить розумний, щоб зрозуміти, як впасти в іншу сторону.

Якщо Бостром і ті, хто з ним погоджуються, дійсно праві, а судячи з усього того, що я встиг прочитати, у них є всі шанси опинитися такими, то нам потрібно буде прийняти два шокуючих факти:

1) Поява ASI вперше відкриє для видів можливість впасти з колоди життя в сторону безсмертя, а не вимирання.

2) Поява ASI чинитиме такий величезний вплив на життя людства, що, швидше за все, зіштовхне людський вид з колоди життя в ту чи іншу сторону.

Дуже ймовірно, що коли процес еволюції підведе нас до цієї бомби, вибух назавжди покладе край людському зв’язку з колодою балансу і створить новий світ з людьми в ньому або без них.

Здається, єдине питання, над яким нам слід шукати відповіді, — в який бік ми звалимося з колоди балансу, коли наступимо на цю бомбу і, власне, коли це все станеться?

Ніхто точно не знає, але багато вчених витратили купу своїх сил і часу, розмірковуючи над цим питанням. Частину допису ми витратимо на дослідження результатів їх діяльності.

Почнемо з першої половини питання: коли ми наступимо на бомбу?

Як довго доведеться чекати, поки машини досягнуть рівня суперінтелекту?

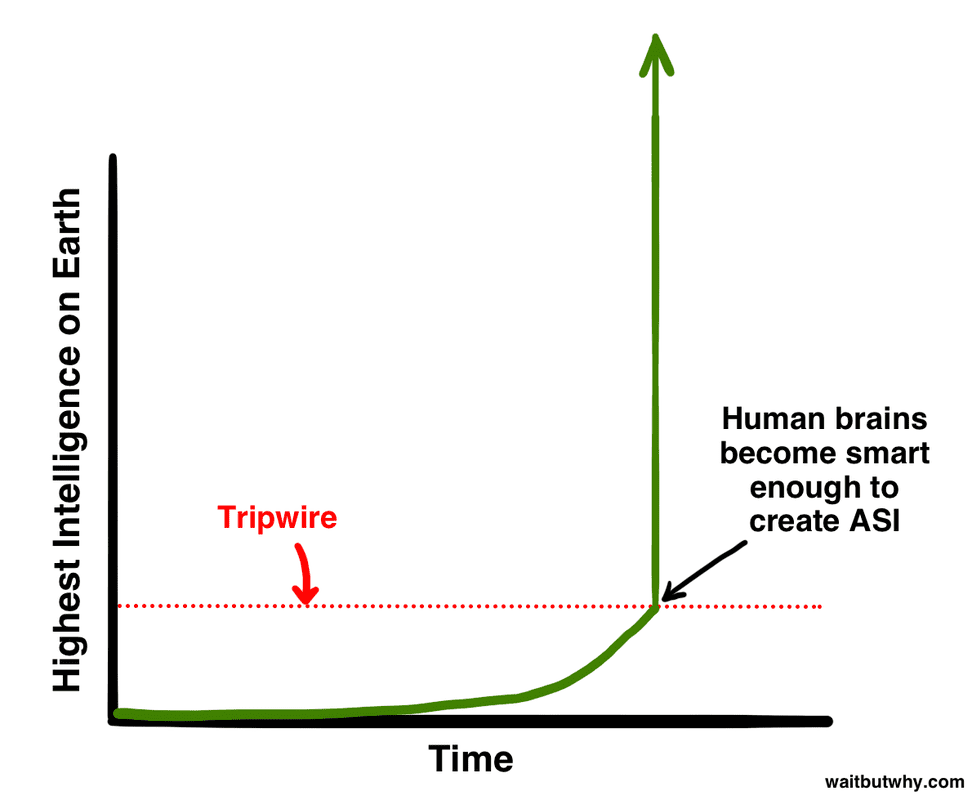

Не дивно, що оцінки абсолютно різняться, і серед вчених відбуваються запеклі суперечки з цього приводу. Більшість, як професор Вернор Віндж, вчений Герцель Бен, співзасновник компанії SUN Microsystems Білл Джой і відомий футуролог та винахідник Рей Курцвейл погоджуються з експертом машинного навчання Джеремі Говардом, коли той презентував наступний графік на Ted Talk:

Всі ці люди переконані, що це станеться скоро — експоненціальне зростання в дії, машини стають все розумнішими, і, хоча поки цей процес здається повільним, ми й отямитися не встигнемо, як вони вже нас обженуть через кілька десятиліть.

Інші, зокрема, співзасновник Microsoft Пола Аллен, психолог досліджень Гарі Маркус, вчений Нью Йоркського університету Ернест Девіс і технопідприємець Мітча Капор вважають, що вчені, подібні Курцвейлу, значно недооцінюють масштаби завдання, і ми не так вже й близькі до вибуху.

Табір Курцвейла, навпаки, вважає, якщо щось і недооцінюється, так це експоненціальне зростання, і порівнює тих, хто сумнівається з тими, хто, дивлячись на розвиток інтернету в 1985 році, вважали, що глобальна мережа не зробить великого впливу на світ в найближчому майбутньому.

Третій табір на чолі з Ніком Бостромом переконаний, що ні у перших, ні в других немає достатніх підстав бути впевненими в своїх прогнозах і вважає, що: А — це може статися в найближчому майбутньому; Б — це може затягнутися, і на значно більший термін.

Звичайно ж, є і такі, в їх числі філософ Г’юберт Дрейфус, які вважають, що всі три табори кумедні і глибоко помиляються: ніякої бомби немає і бути не може, тому що створення ASI неможливо.

Що ми отримаємо склавши докупи усі точки зору разом?

У 2013 році під час кількох конференцій Нік Бостром провів опитування, в якому брали участь сотні експертів у сфері штучного інтелекту. Всім їм потрібно було дати відповідь на одне питання: “Коли, на вашу думку, буде створено штучний інтелект людського рівня?” Їм потрібно було дати оптимістичний прогноз (є шанс в 10%), правдоподібний прогноз (50% впевненості) або безпечне припущення (рік, в якому вже з 90% ймовірністю буде створено AGI). Ось результати зібраних і оброблених даних:

Середній оптимістичний рік (10% ймовірність): 2022

Середній реалістичний рік (50% ймовірність) 2040

Середній песимістичний рік (90% ймовірність): 2075

В середньому опитувані вважають, що, швидше за все, через 25 років AGI стане реальністю. Якщо ви підліток, то, згідно з песимістичним прогнозом, AGI точно з’являться вже при вашому житті. Окреме дослідження нещодавно провів письменник Джеймс Баррат на щорічній конференції Бена Герцеля, присвяченій саме AGI. В опитуванні Баррат пропонував учасникам вибрати зі списку рік, коли буде створений AGI. Варіанти пропонувалися такі: 2030 2050, 2100, пізніше і ніколи. Ось результати:

До 2030: 42% опитаних

До 2050: 25%

До 2100: 20%

Після 2100: 10%

Ніколи: 2%

Ці результати досить схожі на ті, що отримав Бостром. В опитуванні Баррата більше 2/3 учасників заявили, що AGI з’явиться до 2050 року і трохи менше половини вважають, що це відбудеться протягом наступних 15 років. Вражає також, що всього 2 відсотка взагалі не вірять в досягнення AGI.

Але пам’ятайте, що не AGI повинен викликати вибух, а наступний за ним ASI. Коли ж, на думку вчених, з’явиться ASI? Бостром також запитав у експертів, коли, на їхню думку, ми досягнемо суперінтелекту, запропонувавши такі варіанти відповіді: А) в Протягом 2 років (тобто інтелектуальний вибух піде майже негайно) після винаходу AGI; Б) протягом 30 років. Тепер дивимося результат:

За результатами середнього прогнозу, можливість різкого стрибка малоймовірна — всього 10% опитаних, а більш тривалий перехід можливий з вірогідністю в 75%.

Ці дані не дають нам середнього відсотка ймовірності (50%), але з метою приблизного прогнозу, заснованого на двох перерахованих вище відповідях, припустимо, що вони сказали “20 років”. Згідно із середнім прогнозом експертів в галузі AI, за найбільш правдоподібною ймовірністю ми досягнемо суперінтелекту приблизно до 2060 року (2040 рік — поява AGI, плюс наш прогноз 20-річного переходу від AGI до ASI).

Звичайно, всі перераховані вище статистичні дані спекулятивні і являють собою лише думкою серед експертів в галузі AI, але вони показують, що більшість людей, які краще за усіх обізнані в цій сфері, погодилися б, що 2060 — досить вірне припущення для року, коли з’явиться суперінтелект, який змінить світ. До цього моменту нас відокремлює всього лише 45 років.

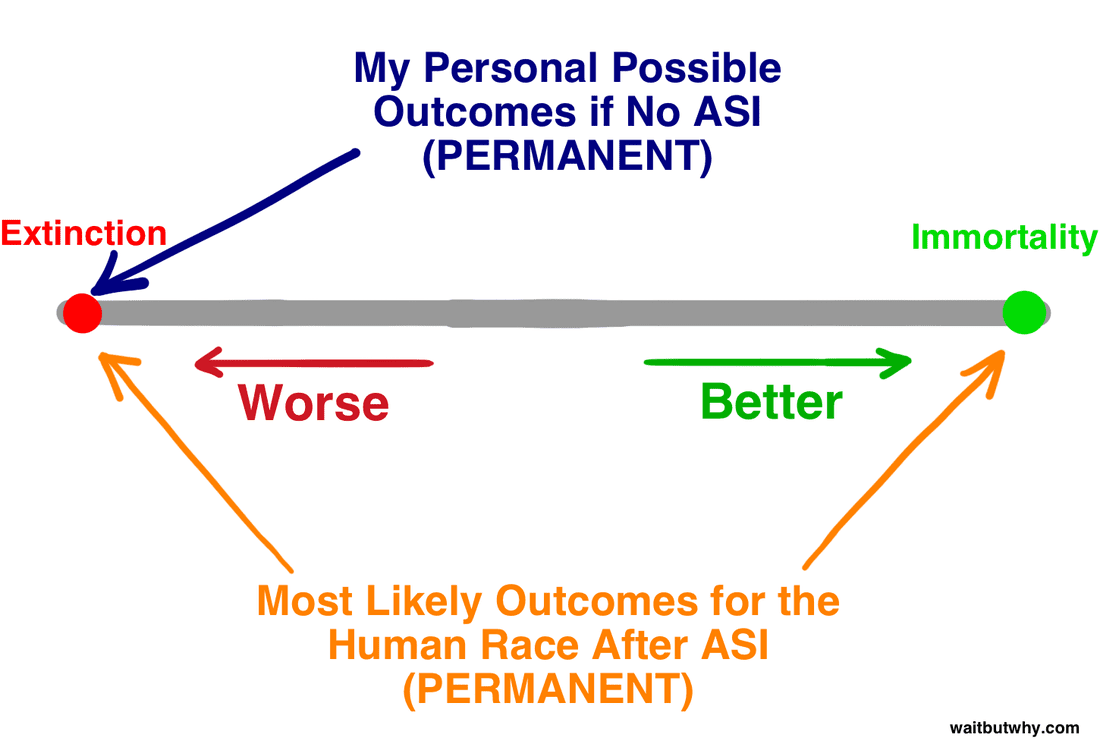

Добре, тепер щодо другої частини запитання — з якого краю колоди ми звалимося, коли відбудеться вибух?

Суперінтелект буде володіти більшою силою, і критичним для нас стане наступне питання:

Хто буде контролювати цю міць і яка в нього буде мотивація?

Залежно від відповіді на нього, ми усвідомимо, чи повинен ASI викликати у нас захоплення або страх.

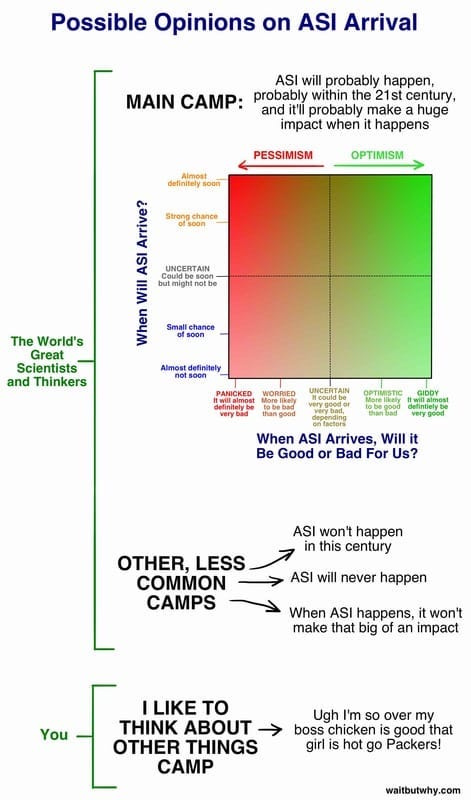

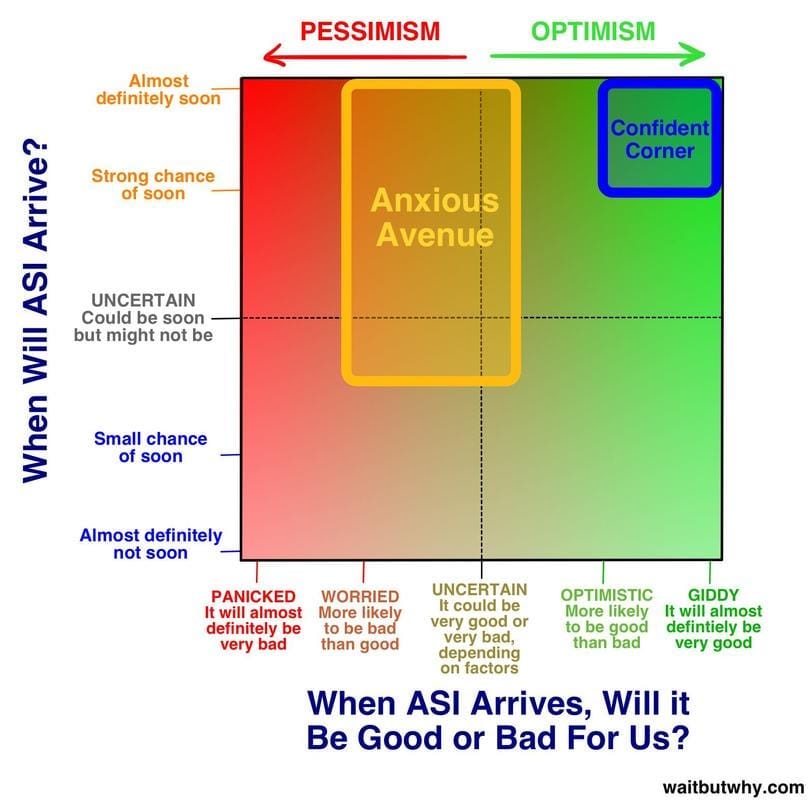

Звичайно ж, наукове співтовариство і тут суттєво розходиться в думках і проводить запеклі суперечки. В опитуванні Бострома учасникам пропонувалося оцінити ймовірність можливих наслідків впливу на людство AGI: 52% вважають, що наслідки будуть хорошими або навіть дуже хорошими; 31% вважають, що наслідки будуть поганими або дуже поганими. Тільки 17% вважають, що наслідки будуть нейтральними. Іншими словами, люди, які найкраще обізнані в цій темі, впевнені, що це все це дуже серйозно. Слід зауважити, що мова тут йшла тільки про AGI, якби питання було про ASI, відсоток з нейтральною оцінкою, найімовірніше, був би набагато нижче.

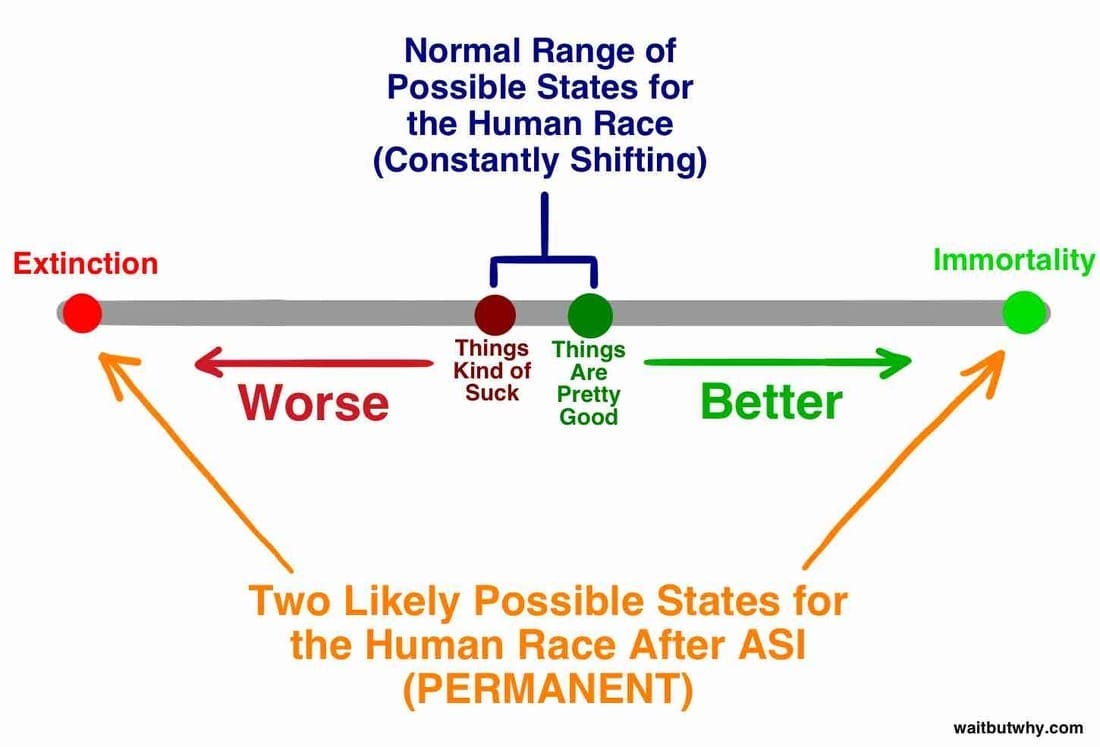

Поки ми ще повністю не заглибилися у всю цю риторику хороших і поганих наслідків, давайте поки об’єднаємо обидві частини запитання «коли це трапиться?» І «чи буде це чимось поганим чи хорошим» в один графік, який поєднує в собі думки більшості відповідних експертів:

Ми поговоримо про лідируючий табір за хвилину, а поки скажіть, чи визначилися ви зі своєю позицією? Насправді, я знаю, що ви скажете, бо я вважав так само, поки не заглибився в дослідження цього питання. Деякі причини, через які люди не особливо замислюються над цією темою:

Як ми вже говорили кіно суттєво заплутало нас, показуючи нереалістичні сценарії розвитку AI, змушуючи нас думати, що AI не є чимось, що варто сприймати всерйоз. Джеймс Баррат порівнює подібну реакцію з тим, якщо б центри з контролю і профілактики захворювань зробили б серйозне попередження про небезпеку, що насувається епідемія зомбі.

Це називається когнітивними забобонами, нам важко повірити в реальність чогось, поки ми не побачимо докази цього. Я впевнений, що вчені в 1988 році постійно обговорювали наскільки серйозним буде розвиток інтернету, але люди не замислювалися про те, як він змінить їхнє життя, поки цього не сталося. Частково це було через те, що комп’ютери в 1988 році не були настільки функціональні, і дивлячись на них, люди не вірили, що ті скоро змінять їх життя. Їх уява була обмежена особистим досвідом і це не дозволяло чітко уявити, чим можуть стати комп’ютери. Те ж саме відбувається зараз і з AI. Ми чуємо, що це все дуже серйозно, але наш досвід, через який ми знаємо відносно слабкі AI, ускладнює для нас можливість повірити в корінні зміни, які принесе суперінтелект.

Навіть якби ми й повірили — скільки разів за день ви замислюєтесь про те, що проведете більшу частину вічності в небутті? Не так багато, вірно? Хоча цей факт більш значущий за будь-яке з ваших повсякденних справ. Наш мозок концентрується в основному на більш дрібних повсякденних завданнях, незалежно від того, наскільки божевільною є довгострокова ситуація, в якій ми знаходимося. Просто ми так влаштовані.

Одна з цілей цього допису — переманити вас з табору «Я люблю думати про інші речі» в один з експертних таборів, навіть якщо ви просто стоїте в абсолютній невпевненості на перетині двох пунктирних ліній в нижній діаграмі.

Під час цього дослідження я натрапив на десятки різних думок з даного питання, але швидко помітив, що їх усі можна об’єднати в один основний табір і, зокрема близько ¾ експертів потрапили в два підтабора всередині головного:

Зараз ми ретельно по всім пройдемо, але давайте почнемо з найцікавішого.

Чому майбутнє може стати для нас солодким сном?

У міру того, як я вивчав світ AI, я виявив, що багато людей перебувають у впевненому куточку на нашому графіку.

Їх погляд спрямований до доброї сторони колоди, і вони переконані, що саме туди ми всі і прямуємо. Для них майбутнє — це все, на що вони так сильно сподівалися і все це настигне вчасно і як не можна доречно.

Що відрізняє їх від інших мислителів, ми обговоримо трохи пізніше, але це не їхня жага виявитися на іншому боці колоди, а їх впевненість, що ми неодмінно приземлимося з протилежного боку.

Звідки береться така впевненість — предмет окремої суперечки. Критики вважають, що ті просто засліплені своєю схвильованістю з приводу майбутнього і не бачать можливих негативних наслідків. Прихильники ж кажуть, що передрікати судний день кумедно, адже технології завжди більшою мірою допомагали нам, ніж шкодили.

Ми охопимо думки обох сторін, і після прочитання ви зможете визначитися з власною точкою зору, але на даному етапі відкладіть свій скептицизм. Пропоную краще подивитись на добру сторону колоди балансу і спробуємо прийняти той факт, що те, про що ви зараз читаєте, цілком може стати реальністю. Якби ви розповіли чоловіку з часів кам’яного віку про наш світ домашнього комфорту, технологій і нескінченного достатку, йому б це могло здатися вигадкою, отже, давайте будемо чесними і визнаємо, що настільки ж незбагненна трансформація може відбутися і в нашому майбутньому.

Нік Бостром описує три можливих типи функціонування AI:

Оракул — з точністю відповідає майже на будь-яке питання, включаючи і складні для людини, наприклад, як створити більш ефективний автомобільний двигун? Google є примітивним видом оракула.

Джинн — виконує будь-яку команду високої складності. Наприклад: використовуй молекулярний асемблер для створення більш ефективного автомобільного двигуна. Після чого чекає нову команду.

Суверен — сам вирішує, як йому краще діяти і які рішення приймати, функціонує незалежно з метою виконати широко поставлену задачу. Наприклад — винайди більш швидкий, економічний і безпечний засіб для приватного пересування людей.

Такі питання і завдання здаються нам дуже складними. Їх виконання для суперінтелекту буде чимось на зразок того, як якщо б нас попросили виправити ситуацію, в якій олівець впав зі столу, і ми б з легкістю виконали завдання, просто піднявши і поклавши олівець назад на стіл.

Еліезер Юдківський, мешканець Тривожного проспекту нашої таблиці, добре підмітив:

“Не існує складних проблем, є тільки проблеми, які складні для певного рівня інтелекту. Підніміться трохи вгору (за рівнем інтелекту), і рішення деяких «неможливих» проблем різко стане «очевидним». Підніметеся на рівень значно вище і все стане «очевидним» “

У впевненому куточку знаходиться безліч непосидючих вчених, винахідників і підприємців, але для екскурсії світлою стороною горизонту AI ми б вважали за краще, щоб нашим гідом був тільки один чоловік.

Персона Рея Курцвейла досить суперечлива. Я натикався на різні відгуки, одні йому вклоняються і обожнюють його ідеї, інші ж зі зневагою закочують очі, почувши його ім’я. Дехто знаходиться посередині, як письменник Дуглас Хофштадтер, який відгукнувся про ідеї викладених в книгах Курцвейла наступним красномовним чином: «Це все одно що змішати гарну їжу з собачим лайном, так що в підсумку неможливо вирішити, гарна вона чи ні». Неважливо, подобаються вам його ідеї чи ні, неможливо не погодитися з тим що особистість Курцвейла, як мінімум, вражає. Вже підлітком він почав свою діяльність, а в наступні десятиліття зробив кілька проривних винаходів, включаючи перший планшетний сканер, перший сканер-перетворювач тексту в мову (дозволяючи сліпим людям читати звичайні книги), добре відомий синтезатор Курцвейла (перше справжнє електричне піаніно) і перший комерційно доступний відтворювач мови з великим словниковим запасом.

Курцвейл написав 5 бестселерів. Він добре відомий за свої сміливі прогнози, значна частина яких виявились вірна, наприклад в 80-х, коли інтернет ще був чимось загадковим, він передбачив, що в 2000-х інтернет стане глобальним феноменом. Wall Street Journal прозвав його «невгамовним генієм», журнал Forbes — «приголомшливою думаючої машиною», журнал Inc — «законним спадкоємцем Едісона», а Білл Гейтс відгукнувся про нього як про «кращого провидця майбутнього AI з усіх, кого він знає».

У 2012 Google співзасновник Ларрі Пейдж запросив Курцвейла зайняти посаду технічного директора. (В інтерв’ю Гардіан Курцвейл пояснив свою місію в Google :. «Моє основне завдання полягає в тому, щоб змусити Google розуміти природну мову, і я вирішую, яким чином цього досягти. Остаточна мета мого проекту полягає в тому, щоб пошук розумів справжнє значення слів. Комп’ютери не здатні сприйняти ідею цієї статті, і ми хочемо, щоб вони насправді навчилися читати. Ми хочемо, щоб комп’ютери змогли прочитати усе в інтернеті, кожну сторінку кожної книги, для того щоб вступити з нами в повноцінний діалог і дати відповіді на наші запитання ». і Google, і Курцвейл вважають, що вся справа в мові).

У 2011 році Курцвей став співзасновником Університету сингулярності, який знаходиться під опікою NASA і частково фінансується Google. Така кількість досягнень — точно непоганий результат для одного життя.

Вся ця біографічна довідка приводиться мною не просто так. Коли Курцвейл формулює своє бачення майбутнього, він звучить як схиблений, але важливо розуміти, що це не так — він разюче розумний і ерудований в цих питаннях. Коротше, вам може здатися, що він не правий, але пам’ятайте, що він далеко не дурень. Усвідомлення того, що це цілком собі пристойний дядько, робить мене щасливим, так як я дуже хочу, щоб його прогнози виправдалися. І ви, напевно, теж.

Нескладно здогадатися, чому у нього так багато пристрасних послідовників, відомих як Сингулярітанці. Більшість його прогнозів широко поділяють вчені з Впевненого куточка, серед яких Пітер Діамандіс і Бен Герцель. Ось що, на їхню думку, має відбутися:

Хронологія

Курцвейл вважає, що до 2029 року ми створимо штучний інтелект, рівний людському, а 2045 в нас буде не тільки суперінтелект, але і повномасштабний новий світ, і цей момент він називає сингулярністю. Такий розрахунок досі продовжує здаватися багатьом шалено перебільшеним (технопідприємець Міч Капор навіть посперечався з Курцвейлом на 200 000 доларів, що ми не досягнемо AGI до 2030 року), але з урахуванням того, як за останні 15 років розвинулися слабкі системи AI, все більше експертів погоджується з Курцвейлом. Його прогноз як і раніше більш амбітний, ніж прогноз середнього учасника Бостромського опитування (AGI — 2040; ASI — 2060), але не так вже й сильно.

На думку Курцвейла, до сингулярності в 2045 нас приведуть три одночасні революції в біотехнологіях, нанотехнологіях і, найбільшою мірою, у сфері розробок AI.

Перш ніж ми рушимо далі, слід сказати, що нанотехнології є невід’ємною частиною всіх розробок, що стосуються AI, так що пропоную зробити невеликий відступ і обговорити нанотехнології.

Відступ про нанотехнології

Нанотехнології — термін для позначення технологій, які мають справу з маніпуляцією матерії, чий розмір варіюється між 1 і 100 нанометрів. Нанометр дорівнює одній мільярдній частині метра або мільйонній частині міліметра. Під цей діапазон від 1 до 100 нм потрапляють віруси (довжиною в 100 нм), ДНК (10Нм в ширину), а також молекули гемоглобіну (5нм), глюкози (1нм) і багато іншого. Якщо нанотехнології стануть підвладні нам, наступним кроком стане можливість маніпулювати атомами, які всього на один порядок величини менше (~ 0,1нм). Наступний крок буде набагато складніше — маніпуляції субатомними частками в ядрі атома, протонами і нейтронами. Вони набагато менше — діаметр протона становить близько 1,7 фемтометра, один фемтометр є однією мільйонною частиною нанометра.

Для того, щоб зрозуміти, в чому полягає складність маніпуляції в подібних масштабах, давайте перенесемо це в масштаби побільше. Міжнародна Космічна станція знаходиться на відстані в 431 км над поверхнею Землі. Якби люди були велетнями і діставали до МКС головою, то вони були б в 250 000 разів більше. Якщо збільшити щось від 1 до 100 нанометрів у 250 000 разів, ви отримаєте 2,5 сантиметра. Продовжуючи порівняння, уявіть, що такий гігант, що чіпляє головою МКС, став би намагатися будувати складні об’єкти, використовуючи інструменти розміром з піщинку.

Для досягнення наступного етапу, маніпуляції атомами, велетню б довелося акуратно працювати з об’єктами, які за своїм розміром складають 1/40 міліметра, настільки дрібними, що навіть звичайним людям потрібен мікроскоп, щоб їх розгледіти. Технологія, яка дозволить людям маніпулювати окремими протонами, порівнянна з гігантом, чий зріст дорівнює відстані від Сонця до Сатурна, який працював би з міліметровою піщинкою. Земля б за розміром становила 1/50 мм і велетню б був потрібний мікроскоп, щоб її розглядати, і в таких умовах йому потрібно було б пересувати з точністю піщинки на Землі. Це все щоб ви зрозуміли, наскільки малий за розміром протон.

Вперше про нанотехнології заговорив Річард Філліпс Фейнман в 1959 році. Тоді він сказав наступне: «Закони фізики, наскільки я можу судити, не суперечать можливості маніпуляції атомами. В принципі, фізик зміг би синтезувати будь-яку хімічну речовину, записану хіміком. Яким чином? Розташувавши атоми там, де попросить хімік». Ось так все просто. Якщо зрозуміти, як переміщати окремі молекули атомів, можна в буквальному сенсі створити що завгодно.

Серйозною сферою науки нанотехнології стали в 1986 році, коли інженер Ерік Дрекслер поклав основи для науки в своїй книзі «Машини творіння». Сам Декслер радить усім, кому цікаві сучасні концепції нанотехнологій, прочитати його нову книгу, що вийшла в 2013 році, — «Радикальний достаток».

Тепер ми зробимо невеликий відступ від відступу, що кумедно.

Невеликий відступ про Сірий Слиз

Я привів вас сюди, щоб розповісти про невеселу частину знання, пов’язану з нанотехнологіями. У попередніх версіях теорії нанотехнологій пропонувався метод нанозбірки, який передбачав створення трильйонів нанороботів, які працюють над чимось разом. Відповідно до одного способу створення трильйону таких роботів, передбачалося, що потрібно зробити лише одного, здатного самовідтворюватися і дозволити йому робити це в геометричній прогресії. Розумно, чи не так?

Розумно, поки це випадково не призведе до глобальної катастрофи. Міць експоненціального зростання робить ідею самореплікаціі дуже привабливою, але з цієї ж самої причини подібна перспектива є жахливою. Що, якщо система заглючить і процес самореплікаціі не зупиниться на парі трильйонів? Для процесу самореплікаціі нанороботам потрібно споживати вуглемісткі матеріали, але вся сіль в тому, що життя на Землі засноване на вуглеці. Біомаса Землі містить близько 10 ^ 45 ступеня атомів вуглецю.

Наноробот повинен складатися з порядку 10 ^ 6 атомів вуглецю, тому 10 ^ 39 нанороботів знищать все життя на Землі, і на це буде потрібно всього 130 реплікацій (2 ^ 130 ~ 10 ^ 39), тоді океан нанороботів (це я і називаю Сірим Слизом) окупує планету. Вчені вважають, що для самореплікаціі нанороботам буде потрібно близько 100 секунд, і це означає, що така помилка знищить все життя на планеті за 3,5 години.

Або сценарій ще гірше — терористи якимось чином опанували технологію нанороботів, при цьому вони знають, як запрограмувати їх таким чином, щоб нанороботи за кілька тижнів непомітно поширилися по всій планеті, і потім одночасно завдали несподіваний удар. Тоді б їм знадобилося всього 90 хвилин на те, щоб знищити життя на Землі і ніхто не зміг би їх зупинити.

Цю страшну версію широко обговорювали кілька років, але гарна новина полягає в тому, що вона ймовірно була сильно перебільшена. Ерік Дрекслер, який ввів термін «сірий слиз», надіслав мені після цього допису імейл, в якому поділився своїми думками історію: «Люди полюбляють страшилки, і цій так само місце поруч з історіями про зомбі, ідея сама по собі виїдає мізки».

Як тільки ми реально розберемося з нанотехнологіями, ми зможемо використовувати їх для створення складних технічних пристроїв, одягу, їжі, біопродуктів — штучних клітин крові, мікровірусів, що знищують ракові клітини, м’язові тканини і т.д. — Та що завгодно, по суті. У світі, де будуть широко застосовуватися нанотехнології, вартість матеріалів буде визначаться не через їх дефіцит та складність виробництва, а через те, наскільки складна їх атомна структура. У світі нанотехнологій алмаз може бути дешевше за ластик.

Але поки ми до цього не дісталися. І неясно, перебільшуємо ми або, навпаки, зменшуємо труднощі цього шляху, але здається, що ми не так далеко. На думку Курцвейла, це станеться до 2020. Уряди різних країн знають, що нанотехнології можуть змінити світ і тому інвестують величезні кошти в їх дослідження (США, Євросоюз і Японія в сукупності витратили на це вже 5 мільярдів доларів).

Важко навіть уявити, які можливості відкриються нам, якщо штучний суперінтелект отримає доступ до наноассемблеру. Але нанотехнології придумала людина, нехай ще поки їх і не освоївши. Враховуючи все те, на що здатний наш розум, для системи ASI він буде кумедним. З цієї самої причини оптимістичний сценарій революції AI пророкує нам речі, які неможливо оцінити, враховуючи їх масштаб. Тому, якщо все це вам здається занадто перебільшеним, візьміть до уваги, що наш мозок навіть не здатний уявити собі ті речі, які можуть відбутись.

Що для нас може зробити AI?

Озброївшись суперінтелектом і всіма технологіями, які він в змозі створити, ASI, швидше за все, зможе вирішити абсолютно всі проблеми людства. Глобальне потепління? Система ASI могла б зупинити викид вуглекислого газу і створити більш ефективний спосіб отримання енергії, який не вимагав би використання природної сировини, після чого ASI створила б інноваційний спосіб усунення надлишків вуглекислого газу з атмосфери. Рак та інші захворювання? Немає проблем, в охороні здоров’я відбудеться така революція, що нам годі й уявити. Світовий голод? ASI використає нанотехнології для створення м’яса, яке буде ідентичне справжньому, точніше, це буде справжнє м’ясо.

Нанотехнології дозволять перетворити будь-яке сміття так, що воно стане м’ясом або будь-яку іншу їжу (уявіть собі квадратні яблука) і поширити її по всій земній кулі, використовуючи надефетивні види перевезень. І тваринам буде чудово, їх перестануть вбивати заради м’яса. ASI зможе запобігти вимиранню видів, що знаходяться під загрозою зникнення і навіть повернути вимерлі види за допомогою збережених зразків їх ДНК. ASI вирішить усі питання макроекономіки та світової торгівлі, покладе край усім філософським суперечкам, так як для ASI все це буде надто очевидно.

Але є одна надзвичайно болісна і цікава річ, на яку здатний ASI.

Суперінтелект може допомогти нам перемогти смерть.

У еволюції не було причин робити наш життєвий цикл більше, ніж він є зараз. Для еволюції досить того, що ми можемо народжувати дітей і ростити їх до тих пір, поки вони не зможуть піклуватися про себе самі. З еволюційної точки зору 30 років вже цілком достатньо для існування нашого виду, тому під час природного відбору для мутацій, які дозволяли б нам жити довше, не було причин. Оскільки усі люди завжди вмирали, ми живемо під страхом смерті і податків, вважаючи, що це неминуче. Ми думаємо про смерть як і про час — як не старайтесь, зупинити їх не можливо. Але таке ствердження хибне. Ось що пише Річард Фейнман:

«Найдивнішим у біологічних науках є те, що немає нічого, що вказувало б на необхідність смерті. У міру відкриття законів фізики стало зрозуміло, що створення вічного двигуна неможливо, інакше закони фізики хибні. Але в біології не було виявлено нічого, що вказувало б на неминучість смерті. Це штовхає мене до думки про те, що лише питання часу, коли саме вчені відкриють причину цієї проблеми, і тоді це жахливе універсальне захворювання (старіння) буде вилікувано ».

Справа в тому, що старіння не пов’язане з часом. Час продовжить свій хід, але старінню це робити не обов’язково. Якщо помислити, то це зовсім не позбавлено сенсу. Старіння — це не більше ніж зношування нашої фізичної оболонки. Деталі автомобіля теж з часом зношуються, але хіба це неминуче? Якщо ідеально лагодити і вчасно замінювати частини автомобіля, то він буде працювати вічно. Людське тіло в цьому плані нічим не відрізняється, тільки воно набагато складніше.

Курцвейл розмірковує про розумних нанороботів, підключених через Wi-Fi до кровообігу, які були б здатні виконувати численні завдання щодо поліпшення нашого здоров’я, включаючи рутинну заміну зношених клітин в будь-якій частині нашого тіла. Якщо довести таку розробку до досконалості (якщо ASI придумає щось крутіше), то наше тіло не просто буде здоровим — ми відвернемо старіння. Різниця Між 60-річним і 30 річним тілом полягає, по суті, в купі фізичних речей, які можна було б замінювати, якби була б в нас така технологія. ASI міг би сконструювати такий собі «освіжувач віку», зайшовши в який, 60-літний чоловік вийшов би з тілом і шкірою 30-річного. Можливості косметичної хірургії стали б безмежні. Навіть деградуючий мозок можна було б поліпшити за допомогою ASI, створивши такий спосіб, який би не пошкодив збережену в ньому інформацію (індивідуальність, спогади і т.д.). 90-річний старець, що страждає хворобою Паркінсона, зайшовши в такий апарат, вийшов би з нього з абсолютно чистим розумом, і був би готовий до початку нової кар’єри. Це може звучати абсурдно, але тіло складається з атомів, і для ASI не склало б ніяких труднощів ними маніпулювати, тому це зовсім не абсурдно.

Курцвейл на цьому не зупиняється. Він вважає, що штучно створені матеріали будуть все частіше імплантуватися в людське тіло. Спочатку органи будуть замінені складними пристроями, які будуть працювати вічно і безвідмовно. Потім ми станемо вносити зміни в структуру тіла, наприклад замінимо червоні кров’яні тільця вдосконаленими еритроцитами нанороботами, які будуть пересуватися самостійно, і серце стане більше не потрібне. Курцвейл не обходить увагою і мозок, стверджуючи, що ми зможемо його вдосконалити таким чином, що станемо думати в мільярди разів швидше і отримувати інформацію ззовні, тому що штучно створені частини мозку дозволять нам підключатися до хмарного сховища інформації.

Супер можливості стануть для людства безмежними. Людям вдалося розмежувати секс як спосіб отримання задоволення і як засіб для репродукції. Курцвейл вірить, що те ж саме можна зробити і з їжею. Нанороботи будуть відповідати за доставку потрібних поживних речовин клітинам організму, виводячи з нього всі шкідливі речовини. Свого роду презерватив для харчування. Теоретик в області нанотехнологій Роберт Фрейтас вже винайшов замінники людських клітин, якщо їх застосувати в тіло людини, вони дозволять спортсмену бігти 15 хвилин без єдиного подиху. Нам залишається лише уявляти, як ASI вплине на наші фізичні можливості.

Віртуальна реальність отримає новий сенс — нанороботи в нашому організмі зможуть придушити сигнали, що посилаються нашими рецепторами і замінити їх абсолютно іншими, дозволяючи нам бачити, чути і відчувати зовсім інший навколишній світ.

В кінцевому підсумку, Курцвейл вважає, що люди стануть повністю штучними, що, звичайно, до кінця не зрозуміло, адже, замінивши все всередині себе, ви як і раніше залишаєтесь собою, але це вже відноситься до питання свідомості. Настане час, коли ми, поглянувши на біологічні тканини, вразимося тим, наскільки вони примітивні. Ми будемо читати в книжках про первинні стадії розвитку, дивуючись тому як інфекції, хвороби і звичайне старіння могли вбити організм людини проти його волі. До цього моменту люди будуть остаточно схрещені з штучним інтелектом.

Так виглядають уявлення Курцвейла про майбутнє, коли люди підкорять біологію і стануть вічними і невразливими. Це інша сторона колоди життя, і ми до неї дійдемо. Зовсім скоро.

Вас не здивує, що ідеї Курцвейла постійно піддаються суворій критиці. Його передбачення про те, що до 2045 року ми досягнемо сингулярності і відкриємо для себе можливість безсмертя, висміювалися як «марення ботанів» або «розумний винахід людей з IQ 140». Інші ставлять під сумнів не лише запропоновану ним хронологію подій, але і його розуміння мозку і тіла, а також і те, що він застосовує закон Мура не тільки до розвитку технічного обладнання а й програмного забезпечення і багатьох іншим речей. На кожного експерта, який вважає, що Курцвейл на вірному шляху, знаходиться троє переконаних у зворотному.

Але мене здивувало більше те, що більшість з незгодних з ним експертів вважають можливим багато з того, про що говорить Курцвейл. Зіткнувшись з таким незвичайним баченням майбутнього, я очікував, що критики будуть говорити: «очевидно, що це неможливо», але вони говорять щось на кшталт «так, це все, звичайно, можливо, якщо перехід до ASI буде безпечним, що малоймовірно». Бостром один з найвідоміших вчених, покликаних попереджувати нас про загрози AI, визнає наступне:

«Складно уявити існування такої проблеми, яку не зміг би вирішити суперінтелект або допомогти розв’язати цю проблему нам. Хвороба, бідність, руйнування навколишнього середовища і будь-які інші страждання: все це зможе вирішити AI, оснащений новітніми нанотехнологіями. Крім того, суперінтелект зміг би продовжити наш життєвий цикл на невизначений термін, зупинивши для цього процес старіння, або надавши нам можливість завантажити себе в хмарне сховище. Суперінтелект міг би створити необхідні умови для збільшення наших інтелектуальних та емоційних можливостей, що допомогло б нам створити неймовірний світ, в якому ми б жили насолоджуючись, присвячуючи себе особистісному зростанню і життю, близькою до наших ідеалів»

І ця цитата належить людині, який зовсім не з Впевненого куточку. З подібним я стикався постійно — фахівці, які знущаються над Курцвейлом через безліч причин, не думають, що все, про що він говорить, неможливо, якщо ми обережно перейдемо до ASI. Ось чому я знаходжу ідеї Курцвейла такими вірусними — вони концентруються на яскравій стороні і цілком реальні, але тільки в разі, якщо Бог виявиться добрим.